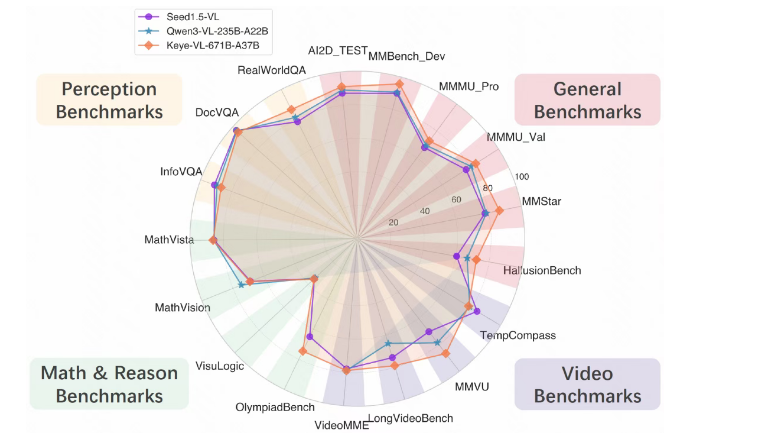

快手近日正式發佈其新一代旗艦多模態模型 Keye-VL-671B-A37B,並同步開放代碼。這一模型以其 “善看會想” 的特性,在通用視覺理解、視頻分析和數學推理等多項核心 benchmark 中表現突出,進一步鞏固了快手在人工智能領域的技術實力。

Keye-VL-671B-A37B 的設計理念在於實現更高層次的多模態理解和複雜推理。該模型在基礎模型的強大通用能力之上,針對視覺感知、跨模態對齊及複雜推理鏈路進行了系統升級,從而提升了其在各種場景下的響應準確性和穩定性。這意味着,無論是日常應用還是高難度任務,Keye-VL-671B-A37B 都能提供更爲精準的結果。

在技術架構方面,Keye-VL-671B-A37B 採用 DeepSeek-V3-Terminus 作爲大語言模型基座,並通過 MLP 層與視覺模型 KeyeViT 相連接,後者則是基於 Keye-VL-1.5進行初始化。模型的預訓練過程分爲三個階段,以系統性地構建其多模態理解與推理能力。通過嚴格篩選的300B 高質量預訓練數據,Keye-VL-671B-A37B 在確保視覺理解能力紮實的同時,控制了計算成本。

具體訓練流程包括凍結視覺與語言模型參數,進行初步對齊訓練,接着開放全部參數進行全面預訓練,最後在更高質量的數據上進行退火訓練,顯著提升模型的細粒度感知能力。此外,模型的後訓練過程涵蓋監督微調、冷啓動和強化學習等步驟,訓練任務涵蓋視覺問答、圖表理解、富文本 OCR 等領域。

快手錶示,未來 Keye-VL 將持續提升基礎模型能力,同時進一步融合多模態 Agent 能力,向更 “會用工具、能解複雜問題” 的智能形態發展。模型的多輪工具調用能力將被強化,使其在實際任務中能夠自主調用外部工具,完成複雜的搜索、推理和信息整合。此外,Keye-VL 還將在 “think with image” 和 “think with video” 等關鍵方向上深入探索,使模型不僅能理解圖像與視頻,還能圍繞這些內容進行深度思考與鏈式推理。

通過基礎能力與 Agent 能力的雙輪驅動,快手的 Keye-VL 目標是不斷拓展多模態智能的上限,邁向更通用、更可靠和更強推理能力的下一代多模態系統。這一創新將爲多模態 AI 的發展帶來新的機遇與挑戰。