在近日举行的技术发布会上,vLLM 团队正式推出了 vLLM-Omni,这是一个面向全模态(omni-modality)模型的推理框架。这一新框架旨在简化多模态推理的过程,并为新一代能够理解和生成多种形式内容的模型提供强有力的支持。与传统的文本输入输出模型不同,vLLM-Omni 可以处理文本、图像、音频和视频等多种输入输出类型。

自项目启动以来,vLLM 团队一直致力于为大型语言模型(LLM)提供高效的推理能力,尤其是在吞吐量和显存使用方面。然而,现代的生成模型已经超越了单一的文本交互,需求多样化的推理能力逐渐成为趋势。vLLM-Omni 正是在这一背景下应运而生,它是首批支持全模态推理的开源框架之一。

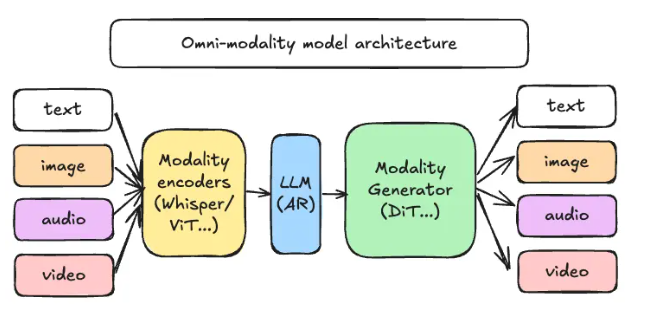

vLLM-Omni 采用了一种全新的解耦流水线架构,通过对数据流的重新设计,能够高效地将不同阶段的推理任务进行分配和协调。在这一架构中,推理请求主要经过三类关键组件:模态编码器、LLM 核心和模态生成器。模态编码器负责将多模态输入转换为向量表示,LLM 核心则处理文本生成和多轮对话,而模态生成器则用于输出图像、音频或视频内容。

这一创新架构的推出,将为工程团队带来诸多便利,允许他们在不同阶段进行独立的资源扩展与部署设计。此外,团队可以根据实际业务需求调整资源分配,从而提高整体工作效率。

GitHub :https://github.com/vllm-project/vllm-omni

划重点:

🌟 vLLM-Omni 是一个全新的推理框架,支持多模态模型处理文本、图像、音频和视频等多种内容。

⚙️ 该框架采用解耦流水线架构,提高了推理效率,并允许针对不同任务进行资源优化。

📚 开源代码和文档已上线,欢迎开发者参与这一新技术的探索与应用。