最近開催された技術発表会で、vLLMチームはvLLM-Omniを正式にリリースしました。これは全モダリティ(omni-modality)モデル向けの推論フレームワークです。この新しいフレームワークは、マルチモーダル推論のプロセスを簡略化し、さまざまな形式のコンテンツを理解・生成できる次世代モデルに対して強力なサポートを提供することを目的としています。従来のテキスト入出力モデルとは異なり、vLLM-Omniはテキスト、画像、音声、動画などのさまざまな入出力タイプを処理できます。

プロジェクト開始以来、vLLMチームは大規模言語モデル(LLM)に高効率な推論能力を提供することに注力してきました、特にスループットとGPUメモリ使用量の面でです。しかし、現代の生成モデルは単一のテキストインタラクションを越えており、多様な推論能力のニーズが徐々にトレンドとなっています。vLLM-Omniはこのような背景の中で登場したものであり、全モダリティ推論をサポートする最初のオープンソースフレームワークの一つです。

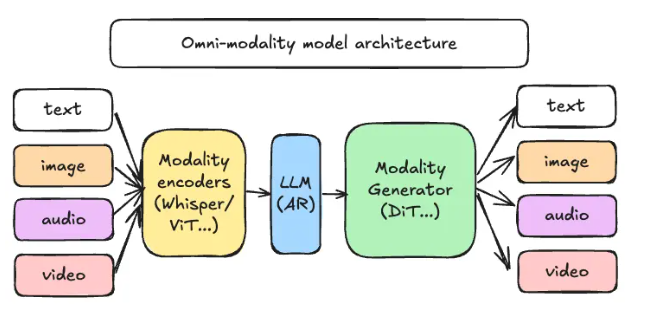

vLLM-Omniは、データフローの再設計を通じて、異なる段階の推論タスクを効率的に割り当ておよび調整できる新たな非結合型パイプラインアーキテクチャを使用しています。このアーキテクチャにおいて、推論要求は主に3つの重要なコンポーネントを通過します:モダリティエンコーダー、LLMコア、モダリティジェネレーター。モダリティエンコーダーはマルチモーダル入力をベクトル表現に変換し、LLMコアはテキスト生成と複数ラウンドの会話を処理し、モダリティジェネレーターは画像、音声、または動画の出力を担当します。

このイノベーションアーキテクチャの導入により、エンジニアリングチームには多くの利便性がもたらされ、異なる段階でのリソース拡張とデプロイ設計を個別に行うことが可能になります。さらに、チームは実際のビジネス要件に基づいてリソース配分を調整することで、全体的な作業効率を向上させることができます。

GitHub :https://github.com/vllm-project/vllm-omni

ポイント:

🌟 vLLM-Omniは、テキスト、画像、音声、動画など、さまざまなコンテンツを処理できる新しい推論フレームワークです。

⚙️ このフレームワークは非結合型パイプラインアーキテクチャを採用しており、推論効率を向上させ、異なるタスクに対するリソース最適化を可能にしています。

📚 オープンソースコードとドキュメントが公開されています。開発者はこの新技術の探索と応用に参加してください。