在近日舉行的技術發佈會上,vLLM 團隊正式推出了 vLLM-Omni,這是一個面向全模態(omni-modality)模型的推理框架。這一新框架旨在簡化多模態推理的過程,併爲新一代能夠理解和生成多種形式內容的模型提供強有力的支持。與傳統的文本輸入輸出模型不同,vLLM-Omni 可以處理文本、圖像、音頻和視頻等多種輸入輸出類型。

自項目啓動以來,vLLM 團隊一直致力於爲大型語言模型(LLM)提供高效的推理能力,尤其是在吞吐量和顯存使用方面。然而,現代的生成模型已經超越了單一的文本交互,需求多樣化的推理能力逐漸成爲趨勢。vLLM-Omni 正是在這一背景下應運而生,它是首批支持全模態推理的開源框架之一。

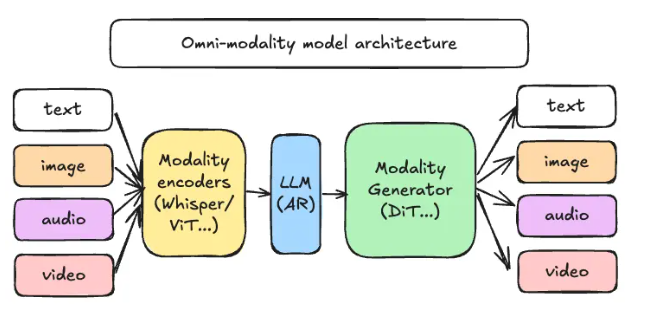

vLLM-Omni 採用了一種全新的解耦流水線架構,通過對數據流的重新設計,能夠高效地將不同階段的推理任務進行分配和協調。在這一架構中,推理請求主要經過三類關鍵組件:模態編碼器、LLM 核心和模態生成器。模態編碼器負責將多模態輸入轉換爲向量表示,LLM 核心則處理文本生成和多輪對話,而模態生成器則用於輸出圖像、音頻或視頻內容。

這一創新架構的推出,將爲工程團隊帶來諸多便利,允許他們在不同階段進行獨立的資源擴展與部署設計。此外,團隊可以根據實際業務需求調整資源分配,從而提高整體工作效率。

GitHub :https://github.com/vllm-project/vllm-omni

劃重點:

🌟 vLLM-Omni 是一個全新的推理框架,支持多模態模型處理文本、圖像、音頻和視頻等多種內容。

⚙️ 該框架採用解耦流水線架構,提高了推理效率,並允許針對不同任務進行資源優化。

📚 開源代碼和文檔已上線,歡迎開發者參與這一新技術的探索與應用。