NVIDIA 最近推出了一种新方法 ——ToolOrchestra,旨在提升 AI 系统选择合适模型和工具的能力,避免传统的单一大型模型依赖。该方法通过训练一个名为 Orchestrator-8B 的小型语言模型,作为多工具使用代理的 “大脑”,实现更高效的任务处理。

目前大多数 AI 代理使用单一大型模型,例如 GPT-5,根据提示选择工具并完成任务。然而,研究发现,这种方法容易导致模型在决策时偏向于使用自身,造成资源浪费。为此,ToolOrchestra 设计了一种专门的控制模型 Orchestrator-8B,利用强化学习来优化工具选择。

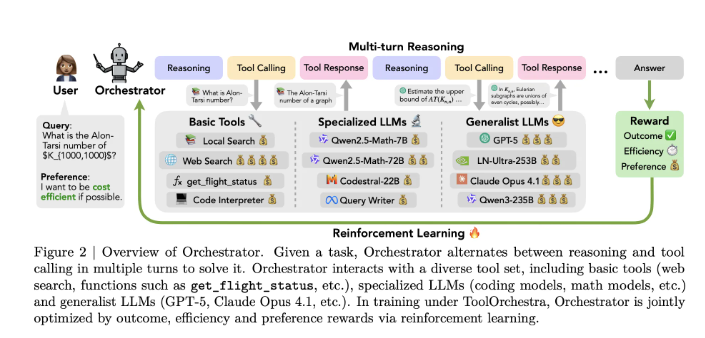

Orchestrator-8B 是一个具有8亿参数的解码器,仅使用 Transformer 结构,通过微调 Qwen3-8B 模型而成。其工作流程分为三个主要步骤:首先,模型解析用户指令及可选的自然语言偏好,例如优先考虑低延迟或避免网络搜索;接着,生成推理过程并计划行动;最后,从可用工具中选择,并以统一的 JSON 格式发出工具调用。这一过程会持续进行,直到任务完成或达到50个步骤的上限。

ToolOrchestra 的强化学习设计包括多个奖励机制,以确保任务的高效完成。具体来说,模型的奖励由三个部分组成:任务成功的二元奖励、效率奖励(针对成本和时间)以及用户偏好奖励。这些因素结合起来,帮助优化策略,使 Orchestrator-8B 在选择和使用工具时更为灵活。

在一系列基准测试中,Orchestrator-8B 表现优异。例如,在 “人类最后的考试” 中,其准确率达到37.1%,高于 GPT-5的35.1%。在效率方面,Orchestrator-8B 的平均成本仅为0.092美元,时间为8.2分钟,远低于 GPT-5的0.302美元和19.8分钟。这表明,Orchestrator-8B 在资源利用和任务处理上表现更佳,适合关注效率和成本的团队。

NVIDIA 的 ToolOrchestra 为复合 AI 系统的构建迈出了重要一步,通过训练特定的路由策略,显著提升了任务处理的效率和准确性。

论文:https://arxiv.org/pdf/2511.21689

划重点:

🧠 Orchestrator-8B 是 NVIDIA 推出的一个8亿参数的小型控制模型,旨在优化多工具使用的效率。

💡 通过强化学习,Orchestrator-8B 能够更灵活地选择和调用工具,减少资源浪费。

📊 在多个基准测试中,Orchestrator-8B 在准确性和效率方面均优于传统的大型模型,如 GPT-5。