StepFun AI 团队近日推出了新的音频大语言模型 Step-Audio-R1,该模型在生成推理时可以有效利用计算资源,解决了当前音频 AI 模型在处理长推理链时准确性下降的问题。研究团队指出,这一问题并非音频模型固有的局限,而是由于训练过程中采用了文本替代推理的方式。

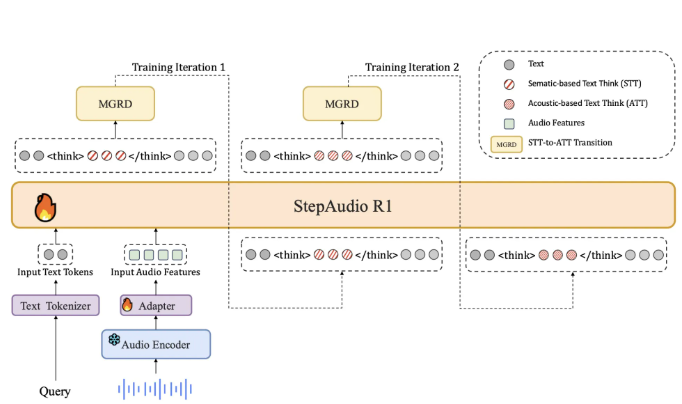

目前大多数音频模型在训练时主要依赖于文本数据,导致它们的推理过程更像是阅读文字,而非实际聆听声音。StepFun 团队称这一现象为 “文本替代推理”。为了应对这一问题,Step-Audio-R1要求模型在生成答案时必须基于音频证据进行推理。这一做法通过一种称为 “模态化推理蒸馏” 的训练方法来实现,该方法特别选取并提炼出与音频特征相关的推理轨迹。

在架构上,Step-Audio-R1基于 Qwen2音频编码器,对原始波形进行处理,并通过音频适配器将输出下采样至12.5Hz。然后,Qwen2.532B 解码器消耗音频特征并生成文本。模型在生成答案时,始终会在特定标签内生成明确的推理块,这样可以确保推理的结构和内容得以优化,同时不影响任务的准确性。

训练过程中,模型经历了监督冷启动阶段和强化学习阶段,涉及文本和音频任务的混合。在冷启动阶段,团队使用了500万例样本,涵盖了1亿个文本标记和40亿个音频配对数据。在这一阶段,模型学习如何生成对音频和文本都有用的推理,并建立了基本的推理能力。

通过多轮 “模态化推理蒸馏”,研究团队从音频问题中提取出真实的声学特征,并用强化学习进一步优化模型的推理能力。Step-Audio-R1在多个音频理解与推理基准测试中表现出色,其综合得分接近行业领先的 Gemini3Pro 模型。

论文:https://arxiv.org/pdf/2511.15848

划重点:

🔊 StepFun AI 推出的 Step-Audio-R1解决了音频推理中的准确性下降问题,采用模态化推理蒸馏方法。

📈 该模型基于 Qwen2架构,能够在推理时明确区分思考过程和最终答案,提升了音频处理能力。

🏆 在多个基准测试中,Step-Audio-R1的表现超过了 Gemini2.5Pro,并与 Gemini3Pro 相当。