StepFun AIチームは最近、新しい音声大規模言語モデル「Step-Audio-R1」をリリースしました。このモデルは、生成と推論の際、計算リソースを効果的に活用でき、現在の音声AIモデルが長く続く推論プロセスにおいて精度が低下する問題を解決しています。研究チームは、この問題は音声モデルの固有の制限ではなく、トレーニング中にテキストを代替して推論を行う方法を採用したためであると指摘しています。

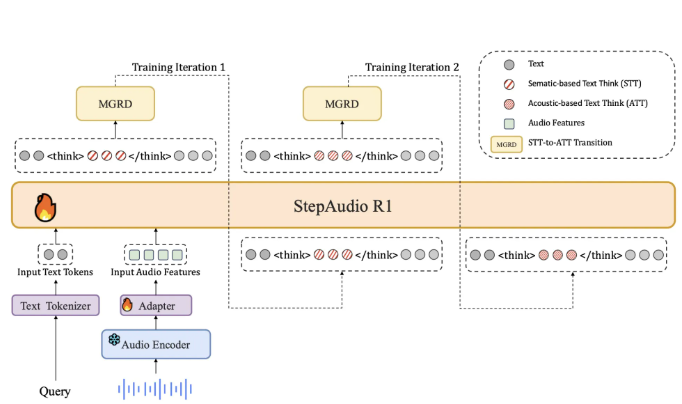

現在、ほとんどの音声モデルはトレーニング時にテキストデータに依存しており、これにより推論プロセスが文字を読むことのように見えるのではなく、実際の音声を聞くこととは異なります。StepFunチームはこれを「テキスト代替推論」と呼びます。この問題に対処するために、Step-Audio-R1では、回答を生成する際に音声の証拠に基づいて推論することが必要です。このアプローチは、「モダリティ推論蒸留」と呼ばれるトレーニング方法によって実現され、音声特徴に関連する推論プロセスが特別に選ばれ、抽出されます。

構造上、Step-Audio-R1はQwen2音声エンコーダーに基づいており、原始的な波形を処理し、音声アダプターを通じて出力を12.5Hzにダウンサンプリングします。その後、Qwen2.532Bデコーダーが音声特徴を消費し、テキストを生成します。モデルが答えを生成する際には、常に特定のタグ内で明確な推論ブロックを生成するように設計されており、これにより推論の構造と内容が最適化されるだけでなく、タスクの正確性には影響を与えません。

トレーニングの過程では、監督付きコールスタート段階と強化学習段階があり、テキストおよび音声のタスクの混合が含まれています。コールスタート段階では、チームは500万件のサンプルを使用し、1億個のテキストトークンと40億個の音声ペアデータをカバーしています。この段階で、モデルは音声とテキストの両方に役立つ推論を生成する方法を学び、基本的な推論能力を構築します。

複数回の「モダリティ推論蒸留」を通じて、研究チームは音声の質問から実際の音響特徴を抽出し、強化学習を用いてモデルの推論能力をさらに最適化しました。Step-Audio-R1は、いくつかの音声理解と推論のベンチマークテストで優れた結果を示しており、総合スコアは業界のリーディングモデルであるGemini3Proに近いです。

論文:https://arxiv.org/pdf/2511.15848

ポイント:

🔊 StepFun AIがリリースしたStep-Audio-R1は、音声推論における精度の低下問題を解決し、モダリティ推論蒸留法を採用しています。

📈 このモデルはQwen2アーキテクチャに基づき、推論時に思考プロセスと最終的な答えを明確に区別できるよう設計されており、音声処理能力が向上しています。

🏆 複数のベンチマークテストにおいて、Step-Audio-R1のパフォーマンスはGemini2.5Proを超え、Gemini3Proと同等です。