StepFun AI 團隊近日推出了新的音頻大語言模型 Step-Audio-R1,該模型在生成推理時可以有效利用計算資源,解決了當前音頻 AI 模型在處理長推理鏈時準確性下降的問題。研究團隊指出,這一問題並非音頻模型固有的侷限,而是由於訓練過程中採用了文本替代推理的方式。

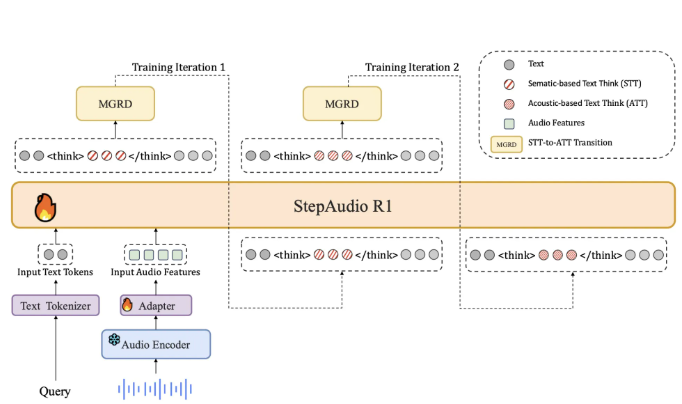

目前大多數音頻模型在訓練時主要依賴於文本數據,導致它們的推理過程更像是閱讀文字,而非實際聆聽聲音。StepFun 團隊稱這一現象爲 “文本替代推理”。爲了應對這一問題,Step-Audio-R1要求模型在生成答案時必須基於音頻證據進行推理。這一做法通過一種稱爲 “模態化推理蒸餾” 的訓練方法來實現,該方法特別選取並提煉出與音頻特徵相關的推理軌跡。

在架構上,Step-Audio-R1基於 Qwen2音頻編碼器,對原始波形進行處理,並通過音頻適配器將輸出下采樣至12.5Hz。然後,Qwen2.532B 解碼器消耗音頻特徵並生成文本。模型在生成答案時,始終會在特定標籤內生成明確的推理塊,這樣可以確保推理的結構和內容得以優化,同時不影響任務的準確性。

訓練過程中,模型經歷了監督冷啓動階段和強化學習階段,涉及文本和音頻任務的混合。在冷啓動階段,團隊使用了500萬例樣本,涵蓋了1億個文本標記和40億個音頻配對數據。在這一階段,模型學習如何生成對音頻和文本都有用的推理,並建立了基本的推理能力。

通過多輪 “模態化推理蒸餾”,研究團隊從音頻問題中提取出真實的聲學特徵,並用強化學習進一步優化模型的推理能力。Step-Audio-R1在多個音頻理解與推理基準測試中表現出色,其綜合得分接近行業領先的 Gemini3Pro 模型。

論文:https://arxiv.org/pdf/2511.15848

劃重點:

🔊 StepFun AI 推出的 Step-Audio-R1解決了音頻推理中的準確性下降問題,採用模態化推理蒸餾方法。

📈 該模型基於 Qwen2架構,能夠在推理時明確區分思考過程和最終答案,提升了音頻處理能力。

🏆 在多個基準測試中,Step-Audio-R1的表現超過了 Gemini2.5Pro,並與 Gemini3Pro 相當。