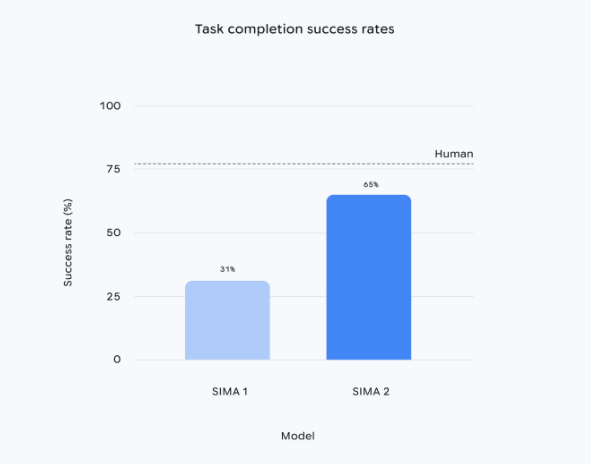

Google DeepMind推出多模态智能体SIMA2,依托Gemini2.5Flash-lite模型,任务成功率较SIMA1提高约一倍,可在未见过的新环境中完成复杂指令,并具备自我改进能力。该版本目前以研究预览形式发布,旨在验证迈向通用机器人与AGI所需的高层级世界理解与推理能力。

SIMA2继续以数百小时游戏视频进行预训练,但首次引入自生成数据循环:进入新场景后,系统调用独立Gemini模型批量生成任务,再由内部奖励模型打分,筛选高质量轨迹用于持续微调,无需额外人工标注即可提升表现。研究团队称,该机制使智能体在《No Man’s Sky》等测试环境中能通过阅读环境文本、识别颜色和符号,自主执行“前往红色房屋”或“砍伐树木”等指令,甚至可理解emoji组合命令。

DeepMind在演示中结合生成式世界模型Genie,为SIMA2即时生成逼真户外场景,智能体可准确识别长椅、树木、蝴蝶等对象并交互。高级研究科学家Jane Wang表示,这种“看懂场景→推断目标→规划动作”的闭环,正是把虚拟环境能力迁移至真实机器人所必需的高层行为模块。

不过,SIMA2目前聚焦于高层决策,不涉及机械关节、轮子等底层控制。DeepMind同期训练的机器人基础模型采用不同技术路线,两者如何融合尚未确定。团队拒绝透露正式版发布时间,仅称希望通过预览吸引外部合作,共同探索虚拟智能体向实体机器人迁移的可行路径。