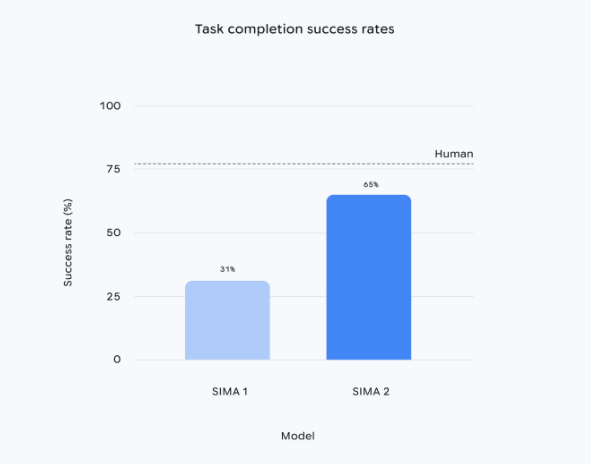

Google DeepMindはマルチモーダルなインテリジェントエージェント「SIMA2」を発表しました。このシステムはGemini2.5Flash-liteモデルを基盤としており、SIMA1に比べてタスクの成功率が約2倍となりました。また、見たことのない新しい環境でも複雑な指示を実行でき、自己改善能力も備えています。今回のバージョンは研究プレビュー形式で公開されており、汎用ロボットとAGI(人工一般知能)への道のりにおいて必要な高レベルな世界理解と推論能力を検証するためのものです。

SIMA2は数百時間分のゲーム動画を元に事前学習していますが、今回は初めて自生成データのループを導入しています。新規のシーンに入ると、システムは独立したGeminiモデルを呼び出して一括でタスクを生成し、内部の報酬モデルによってスコアリングを行い、高品質な軌跡を選別して継続的な微調整に使用します。これにより、追加の人間によるラベリングなしで性能を向上させることができます。研究チームによると、このメカニズムにより、『No Man’s Sky』などのテスト環境で、環境のテキストを読み取り、色や記号を識別し、「赤い家へ行く」や「木を切る」などの指示を自律的に実行できるほか、絵文字の組み合わせによる命令も理解できるようになります。

DeepMindはデモで生成型ワールドモデル「Genie」と連携させ、SIMA2にリアルな屋外シーンを即座に生成させました。この際、エージェントはベンチや木、蝶などオブジェクトを正確に認識し、インタラクティブに操作できます。上級研究科学者であるJane Wang氏は、「シーンを理解→目標を推測→行動を計画」という閉ループが、仮想環境の能力を現実のロボットに移すために必要な高次の行動モジュールであると語っています。

ただし、現在のSIMA2は高次の意思決定に焦点を当てており、機械の関節やホイールなどの低次の制御には関与していません。DeepMindは同時にロボットの基本モデルを訓練しており、異なる技術的アプローチを採用しています。これらがどのように統合されるかはまだ明確ではありません。チームは正式版のリリース日については明らかにしておらず、プレビューを通じて外部との協力を引きつけ、仮想エージェントから実体ロボットへの移行の可能性を探求したいと考えていると語っています。