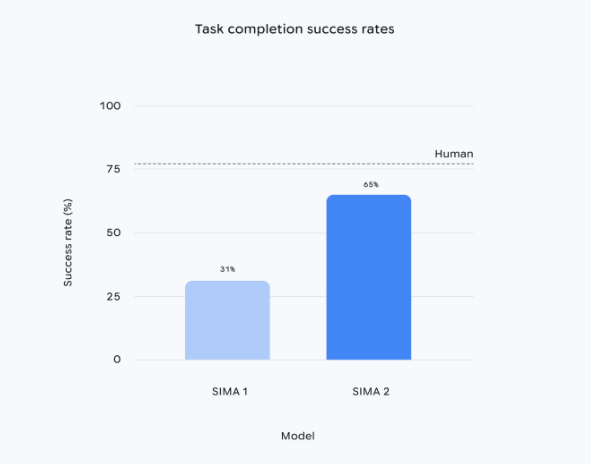

Google DeepMind推出多模態智能體SIMA2,依託Gemini2.5Flash-lite模型,任務成功率較SIMA1提高約一倍,可在未見過的新環境中完成複雜指令,並具備自我改進能力。該版本目前以研究預覽形式發佈,旨在驗證邁向通用機器人與AGI所需的高層級世界理解與推理能力。

SIMA2繼續以數百小時遊戲視頻進行預訓練,但首次引入自生成數據循環:進入新場景後,系統調用獨立Gemini模型批量生成任務,再由內部獎勵模型打分,篩選高質量軌跡用於持續微調,無需額外人工標註即可提升表現。研究團隊稱,該機制使智能體在《No Man’s Sky》等測試環境中能通過閱讀環境文本、識別顏色和符號,自主執行“前往紅色房屋”或“砍伐樹木”等指令,甚至可理解emoji組合命令。

DeepMind在演示中結合生成式世界模型Genie,爲SIMA2即時生成逼真戶外場景,智能體可準確識別長椅、樹木、蝴蝶等對象並交互。高級研究科學家Jane Wang表示,這種“看懂場景→推斷目標→規劃動作”的閉環,正是把虛擬環境能力遷移至真實機器人所必需的高層行爲模塊。

不過,SIMA2目前聚焦於高層決策,不涉及機械關節、輪子等底層控制。DeepMind同期訓練的機器人基礎模型採用不同技術路線,兩者如何融合尚未確定。團隊拒絕透露正式版發佈時間,僅稱希望通過預覽吸引外部合作,共同探索虛擬智能體向實體機器人遷移的可行路徑。