近日,英偉達研究團隊發佈了全新的 OmniVinci 全模態理解模型,該模型在多個全模態理解基準測試中,表現出色,超越了目前最頂尖的模型19.05分。更令人矚目的是,OmniVinci 在訓練過程中僅使用了0.2萬億的訓練 Token,相較於競爭對手的1.2萬億,其數據效率是其六倍。

OmniVinci 的核心目標是打造一個可以同時理解視覺、音頻和文本的人工智能系統,使機器能夠像人類一樣,通過不同感官感知和理解複雜的世界。爲了實現這一目標,研究團隊不僅僅是簡單地增加數據量,而是通過創新的網絡架構和數據管理策略,成功實現了性能和效率的雙重提升。

在設計上,OmniVinci 採用了全模態潛在空間的概念,旨在融合來自不同感官的信息,實現跨模態的理解與推理。研究團隊發現,不同模態之間在感知和推理層面能夠相互強化,這一發現爲多模態 AI 系統的構建指明瞭方向。

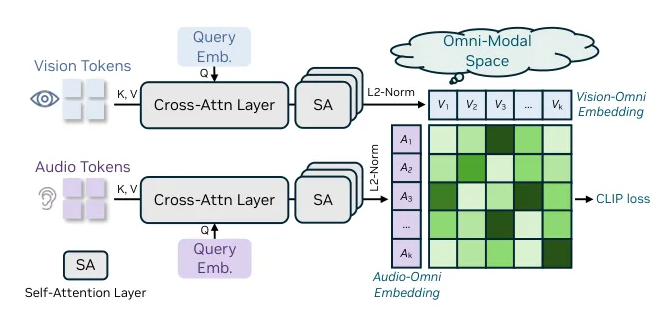

OmniVinci 的架構設計具有可組合的跨模態理解能力,整合了圖像、視頻、音頻和文本等異構輸入。通過統一的全模態對齊機制,該模型能夠將不同模態的嵌入信息整合到一個潛在空間中,進一步輸入到大語言模型(LLM)中。該機制包括三項關鍵技術,其中 OmniAlignNet 模塊有效對齊視覺和音頻信息,而時間嵌入分組和約束旋轉時間嵌入則提升了模型對時間信息的理解。

爲了培養 OmniVinci 的全模態理解能力,研究團隊採用了兩階段的訓練方法。首先是模態特定訓練,接着進行全模態聯合訓練,利用隱式和顯式學習數據,顯著提升了模型的聯合理解能力。

隨着 OmniVinci 的發佈,英偉達再次展示了其在人工智能領域的技術創新,預示着未來 AI 系統將更加智能、靈活。

github:https://github.com/NVlabs/OmniVinci

劃重點:

🌟 OmniVinci 模型在全模態理解基準測試中超越了頂尖模型19.05分。

📊 訓練數據量僅爲競爭對手的1/6,數據效率提升至六倍。

🔑 採用創新架構和兩階段訓練方法,顯著提升模型的多模態理解能力。