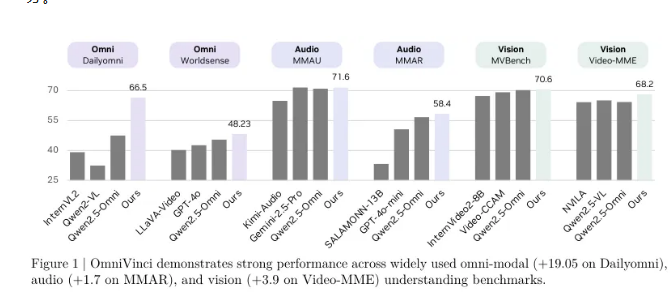

英偉達研究團隊今日發佈了名爲 OmniVinci 的全模態理解模型,該模型在關鍵的全模態理解基準測試中取得了驚人的成果,相較於現有頂尖模型高出19.05分。更爲引人注目的是,OmniVinci 僅使用了1/6的訓練數據,展現出卓越的數據效率和性能。

OmniVinci 的目標是創建一個能夠同時理解視覺、音頻和文本的全能 AI 系統,使機器能夠像人類一樣通過多種感官感知並理解複雜的世界。爲了實現這一目標,英偉達團隊採取了創新的架構設計和數據管理策略,通過一個統一的全模態潛在空間,將不同感官的信息融合在一起,實現了跨模態的理解和推理。

在 Dailyomni 基準測試中,OmniVinci 的表現超過了 Qwen2.5-Omni,其在音頻理解的 MMAR 測試中高出1.7分,在視覺理解的 Video-MME 測試中高出3.9分。使用的訓練 Token 僅爲0.2萬億,而 Qwen2.5-Omni 的訓練量爲1.2萬億,顯示出 OmniVinci 的訓練效率是其6倍。

該模型的核心創新在於全模態對齊機制,包括 OmniAlignNet 模塊、時間嵌入分組(TEG)和約束旋轉時間嵌入(CRTE)三項技術。OmniAlignNet 利用視覺和音頻信號之間的互補性,加強了兩者的學習與對齊。而 TEG 則通過將視覺和音頻信息按時間分組,有效編碼了時間關係。CRTE 則進一步解決了時間對齊問題,確保模型能夠理解事件的絕對時間信息。

研究團隊採用了兩階段的訓練方法,首先進行模態特定訓練,隨後進行全模態聯合訓練,以逐步提升模型的全模態理解能力。在隱式全模態學習方面,研究者們通過現有的視頻問答數據集,進一步提高了模型對音視頻的聯合理解能力。

OmniVinci 的問世標誌着英偉達在多模態 AI 領域的重要突破,預計將在各類應用中推動 AI 技術的發展,助力更智能的系統和服務的出現。該模型的開源發佈,也將爲全球的研究人員和開發者提供新的機遇,推動 AI 在實際應用中的進一步探索與創新。