最近、NVIDIAの研究チームは、新しいオムニビンシというマルチモーダル理解モデルを発表しました。このモデルは、複数のマルチモーダル理解ベンチマークテストで優れた性能を示し、現在最も高性能なモデルを19.05ポイント上回りました。さらに注目すべきは、オムニビンシがトレーニング中に使用したトレーニングトークンが0.2テラにとどまり、競合他社の1.2テラに比べてデータ効率が6倍であることです。

オムニビンシの主な目的は、視覚、音声、テキストを同時に理解できる人工知能システムを構築することです。これにより、機械は人間のように、異なる感覚を通じて複雑な世界を感知し理解できるようになります。この目標を達成するために、研究チームは単純にデータ量を増やすだけでなく、イノベーティブなネットワークアーキテクチャとデータ管理戦略を採用することで、パフォーマンスと効率の両方を向上させることに成功しました。

デザイン面では、オムニビンシはすべてのモーダル潜在空間の概念を採用しており、異なる感覚からの情報を統合し、モーダル間の理解と推論を実現することを目的としています。研究チームは、異なるモーダルが知覚や推論のレベルで相互に強化できることを発見し、これによりマルチモーダルAIシステムの構築の方向性が示されました。

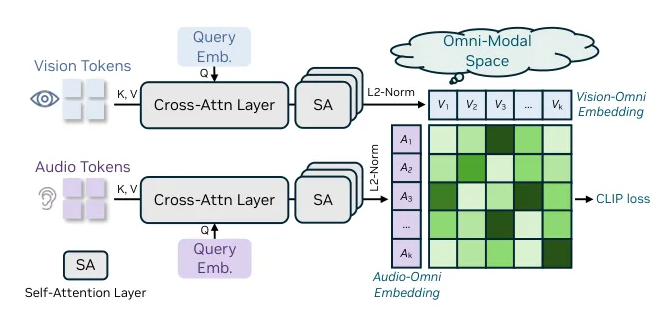

オムニビンシのアーキテクチャ設計には、組み合わせ可能なクロスモーダル理解能力があり、画像、動画、音声、テキストなどの非一貫した入力を統合しています。統一された全モーダルアライメントメカニズムにより、このモデルは異なるモーダルの埋め込み情報を1つの潜在空間に統合し、それを大規模言語モデル(LLM)に入力します。このメカニズムには3つの重要な技術が含まれており、その中でもOmniAlignNetモジュールは視覚と音声情報の効果的なアライメントを担っています。また、時間埋め込みグループ化と制約付き時間埋め込みは、モデルが時間情報の理解を向上させています。

オムニビンシの全モーダル理解能力を育成するため、研究チームは2段階のトレーニング方法を採用しました。まず、モーダル固有のトレーニングを行い、その後、全モーダルの共同トレーニングを行いました。隠れ学習と明示的な学習データを使用することで、モデルの共同理解能力を顕著に向上させました。

オムニビンシのリリースにより、NVIDIAは再び人工知能分野での技術革新を示し、今後のAIシステムがよりスマートで柔軟になることを示唆しています。

github:https://github.com/NVlabs/OmniVinci

ポイント:

🌟 オムニビンシモデルは、全モーダル理解ベンチマークテストでトップモデルを19.05ポイント上回りました。

📊 トレーニングデータ量は競合の1/6であり、データ効率は6倍に向上しました。

🔑 イノベーティブなアーキテクチャと2段階のトレーニング方法により、モデルのマルチモーダル理解能力が大幅に向上しました。