在人工智能圖像編輯與生成領域,一項新的突破性技術引起了廣泛關注。字節跳動與香港中文大學、香港科技大學和香港大學聯合研發的 DreamOmni2系統,已正式開源,標誌着圖像編輯生成技術的最新發展。

DreamOmni2的推出,致力於提升人工智能在圖像處理中的指令遵循能力,實現了真正的多模態指令理解。這一系統能夠同時理解文本指令與參考圖像,顯著改善了以往模型在處理抽象概念(如風格、材質、光照)時的侷限性。用戶與 AI 之間的交互更加自然,彷彿與一個瞭解自己意圖的合作伙伴對話。

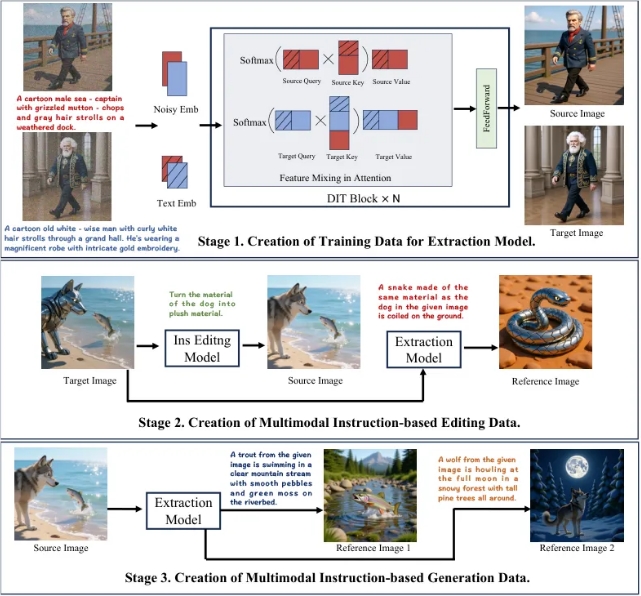

爲了訓練 AI 理解複雜的文本和圖像指令,DreamOmni2的研發團隊開發了一套創新的三階段流程。首先,通過訓練提取模型,AI 能夠精準提取圖像中的特定元素或抽象屬性。接着,利用提取模型生成多模態指令編輯數據,形成包含源圖像、指令、參考圖像和目標圖像的訓練樣本。最後,通過進一步提取與組合生成更多參考圖像,構建出豐富的多模態指令生成數據集。這一系列步驟爲系統的高質量訓練打下了堅實基礎。

在模型架構方面,DreamOmni2提出了索引編碼和位置編碼偏移方案,確保模型能夠準確識別多張輸入圖像。同時,引入視覺語言模型(VLM),有效解決了用戶指令與模型理解之間的鴻溝。這種創新設計提升了系統在處理指令時的準確性,使其能夠更好地理解用戶的真實意圖。

經過測試,DreamOmni2在多模態指令編輯任務上的表現超越了所有參與比較的開源模型,接近頂尖商業模型。與傳統的商業模型相比,DreamOmni2在處理複雜指令時,能夠提供更高的準確性和一致性,避免了不必要的變更和圖像瑕疵。

DreamOmni2的開源,不僅爲 AI 創作提供了新的可能性,也爲相關領域的研究者提供了統一的評判標準。這一技術的發佈,預示着 AI 圖像編輯與生成領域即將迎來新的革命。對於未來的發展,業內專家表示,DreamOmni2的成功將極大推動 AI 技術的普及和應用。