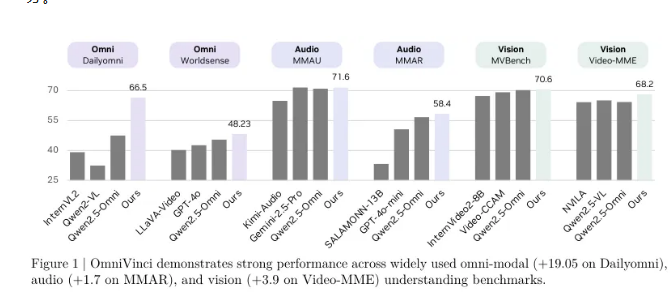

NVIDIAの研究チームは、OmniVinciと呼ばれるマルチモーダル理解モデルを発表しました。このモデルは、重要なマルチモーダル理解ベンチマークテストで驚くべき成果を収め、既存のトップモデルより19.05ポイント高いスコアを記録しました。さらに注目すべきは、OmniVinciが使用したトレーニングデータが1/6にとどまっていることで、優れたデータ効率性と性能を示しています。

OmniVinciの目的は、視覚、音声、テキストを同時に理解できる包括的なAIシステムを作ることです。これにより、機械が人間のように多様な感覚を通じて複雑な世界を認識し理解できるようになります。この目標を達成するために、NVIDIAチームは革新的なアーキテクチャ設計とデータ管理戦略を採用し、統一されたマルチモーダル潜在空間を介して、異なる感覚情報を統合することで、マルチモーダルな理解と推論を実現しました。

Dailyomniベンチマークテストでは、OmniVinciはQwen2.5-Omniを上回り、音声理解のMMARテストでは1.7ポイント、視覚理解のVideo-MMEテストでは3.9ポイント高いスコアを記録しました。トレーニング用トークンは0.2兆にとどまり、Qwen2.5-Omniのトレーニング量1.2兆に対して、OmniVinciのトレーニング効率はその6倍であることがわかりました。

このモデルの核心的なイノベーションは、マルチモーダル対齊メカニズムであり、OmniAlignNetモジュール、時間埋め込みグループ(TEG)、制約回転時間埋め込み(CRTE)という3つの技術が含まれます。OmniAlignNetは視覚と音声信号の相補性を利用して、両者の学習と対齊を強化します。一方、TEGは視覚と音声情報を時間ごとにグループ化し、時間的関係を効果的に符号化します。CRTEはさらに時間対齊問題を解決し、モデルがイベントの絶対的な時間情報の理解を保証します。

研究チームは、2段階のトレーニング方法を採用しました。最初にモード固有のトレーニングを行い、その後、マルチモーダル連合トレーニングによって徐々にモデルのマルチモーダル理解能力を向上させました。暗黙的なマルチモーダル学習においては、既存の動画質問応答データセットを活用し、モデルの音声・映像の連合理解能力をさらに高めました。

OmniVinciの登場は、NVIDIAがマルチモーダルAI分野で重要な突破を遂げたことを示しており、さまざまなアプリケーションでAI技術の進展を促進し、よりスマートなシステムやサービスの登場を支援する予定です。このモデルのオープンソース公開は、グローバルな研究者や開発者にとって新たな機会を提供し、実際の応用におけるAIのさらなる探求と革新を促進するでしょう。