谷歌最近发布了一款名为 BlenderFusion 的创新框架,旨在提升3D 视觉编辑与生成合成的能力。这一新工具的推出,响应了当前图像生成领域的需求,特别是在复杂场景的处理上。传统的生成对抗网络和扩散模型在生成整体图像方面表现出色,但对于多个视觉元素的精确控制却相对有限。BlenderFusion 的诞生,为这一挑战提供了新的解决方案。

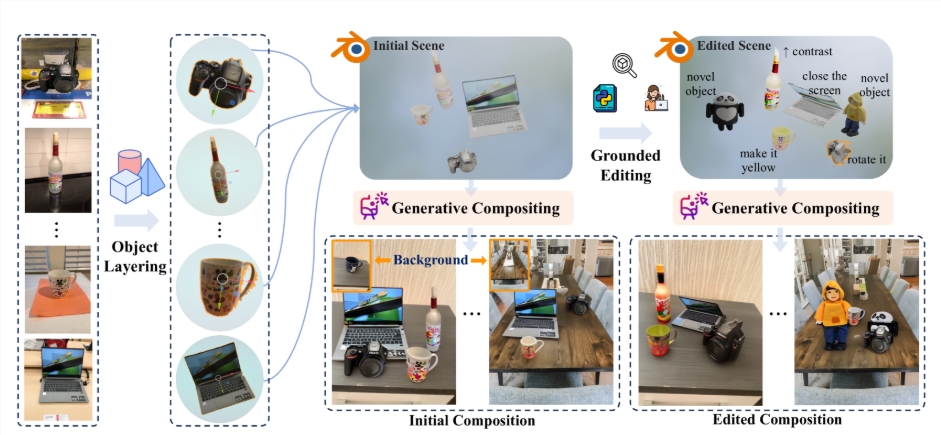

BlenderFusion 的工作流程主要分为三个阶段:分层、编辑和合成。首先,在分层阶段,BlenderFusion 会从输入的2D 图像中提取可编辑的3D 对象。研究人员使用了多种前沿的视觉基础模型,如 SAM2和 DepthPro,以便更准确地识别图像中的物体。通过这些模型,系统可以生成物体的3D 点云,为后续编辑奠定基础。

接下来,编辑阶段则充分发挥了 Blender 的强大功能。用户可以对导入的3D 实体进行多种操作,如移动、旋转和缩放等,甚至可以对物体的外观和材质进行精细调整。这一过程让用户能够灵活处理场景中的每一个元素,使得每次编辑都能高效反映在最终的渲染效果中。

在合成阶段,BlenderFusion 将经过编辑的3D 场景与背景进行融合,生成最终的图像。这一阶段依赖于强大的生成合成器,能够处理来自不同输入的细节信息,确保最终效果的高质量和连贯性。研究团队对现有的扩散模型进行了优化,使其能够有效整合编辑和源场景信息,从而提升合成效果。

通过 BlenderFusion,谷歌不仅展示了其在3D 视觉编辑领域的技术创新,还为用户提供了一种新的创作工具,使得复杂的视觉任务变得更加直观和高效。这一框架的推出,必将为设计师和创作者们的工作带来便利。

项目:https://blenderfusion.github.io/

划重点:

🌟 BlenderFusion 集成了先进的3D 编辑工具与扩散模型,实现了高效的3D 视觉编辑与生成合成。

🛠️ 该框架的工作流程包括分层、编辑和合成三个阶段,用户可以方便地编辑3D 对象并生成最终图像。

📈 谷歌的 BlenderFusion 通过优化模型,提升了对复杂场景的处理能力,助力设计师实现创意。