谷歌最近發佈了一款名爲 BlenderFusion 的創新框架,旨在提升3D 視覺編輯與生成合成的能力。這一新工具的推出,響應了當前圖像生成領域的需求,特別是在複雜場景的處理上。傳統的生成對抗網絡和擴散模型在生成整體圖像方面表現出色,但對於多個視覺元素的精確控制卻相對有限。BlenderFusion 的誕生,爲這一挑戰提供了新的解決方案。

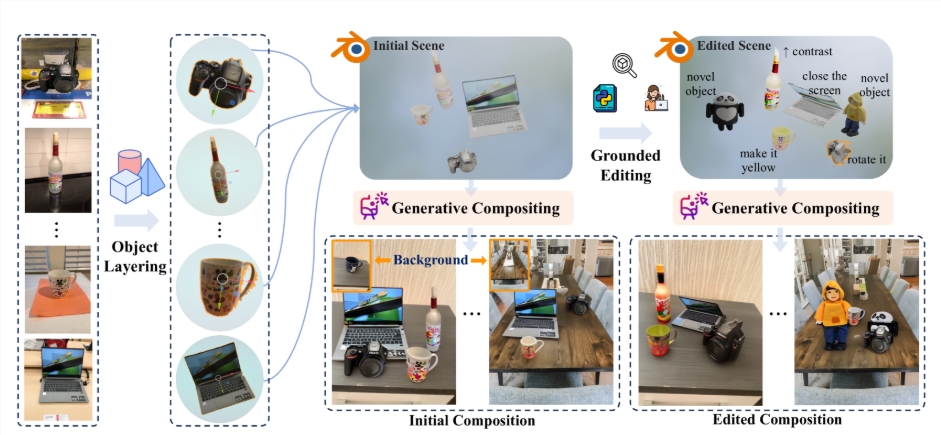

BlenderFusion 的工作流程主要分爲三個階段:分層、編輯和合成。首先,在分層階段,BlenderFusion 會從輸入的2D 圖像中提取可編輯的3D 對象。研究人員使用了多種前沿的視覺基礎模型,如 SAM2和 DepthPro,以便更準確地識別圖像中的物體。通過這些模型,系統可以生成物體的3D 點雲,爲後續編輯奠定基礎。

接下來,編輯階段則充分發揮了 Blender 的強大功能。用戶可以對導入的3D 實體進行多種操作,如移動、旋轉和縮放等,甚至可以對物體的外觀和材質進行精細調整。這一過程讓用戶能夠靈活處理場景中的每一個元素,使得每次編輯都能高效反映在最終的渲染效果中。

在合成階段,BlenderFusion 將經過編輯的3D 場景與背景進行融合,生成最終的圖像。這一階段依賴於強大的生成合成器,能夠處理來自不同輸入的細節信息,確保最終效果的高質量和連貫性。研究團隊對現有的擴散模型進行了優化,使其能夠有效整合編輯和源場景信息,從而提升合成效果。

通過 BlenderFusion,谷歌不僅展示了其在3D 視覺編輯領域的技術創新,還爲用戶提供了一種新的創作工具,使得複雜的視覺任務變得更加直觀和高效。這一框架的推出,必將爲設計師和創作者們的工作帶來便利。

項目:https://blenderfusion.github.io/

劃重點:

🌟 BlenderFusion 集成了先進的3D 編輯工具與擴散模型,實現了高效的3D 視覺編輯與生成合成。

🛠️ 該框架的工作流程包括分層、編輯和合成三個階段,用戶可以方便地編輯3D 對象並生成最終圖像。

📈 谷歌的 BlenderFusion 通過優化模型,提升了對複雜場景的處理能力,助力設計師實現創意。