近日,阿里语音AI团队宣布开源全球首个支持链式推理的音频生成模型ThinkSound,该模型通过引入思维链(Chain-of-Thought)技术,突破传统视频转音频技术对画面动态捕捉的局限,实现高保真、强同步的空间音频生成。这一突破标志着AI音频技术从“看图配音”向“结构化理解画面”的跨越式发展。

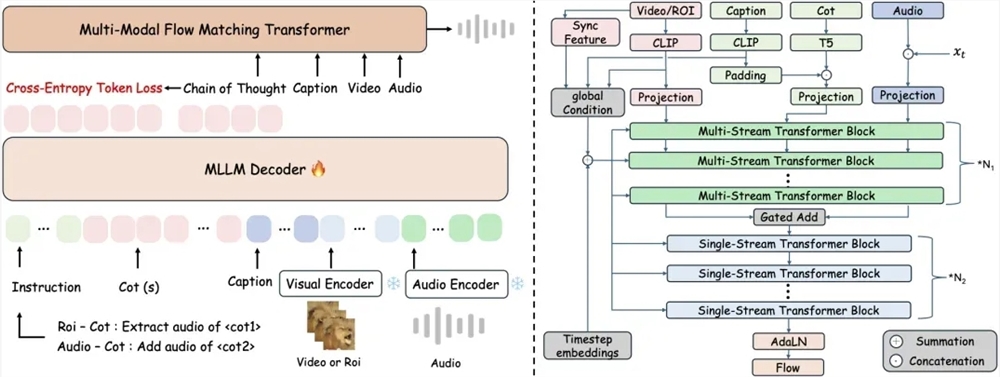

传统端到端视频转音频技术常因忽视画面细节与声音的时空关联,导致生成音频与视觉事件错位。ThinkSound首次将多模态大语言模型与统一音频生成架构结合,通过三阶段推理机制实现精准音频合成:系统首先解析画面整体运动与场景语义,生成结构化推理链;随后聚焦具体物体声源区域,结合语义描述细化声音特征;最终支持用户通过自然语言指令实时交互编辑,例如“在鸟鸣后添加树叶沙沙声”或“移除背景噪声”。

为支撑模型的结构化推理能力,研究团队构建了包含2531.8小时高质量样本的AudioCoT多模态数据集,整合VGGSound、AudioSet等来源的动物鸣叫、机械运转等真实场景音频。数据集通过多阶段自动化过滤与人工抽样校验确保质量,并特别设计对象级和指令级样本,使模型可处理“提取猫头鹰鸣叫时避免风声干扰”等复杂指令。

实验数据显示,ThinkSound在VGGSound测试集的核心指标上较主流方法提升超15%,在MovieGen Audio Bench测试集中表现大幅领先Meta同类模型。目前,该模型的代码与预训练权重已在GitHub、HuggingFace及魔搭社区开源,开发者可免费获取。

阿里语音AI团队透露,未来将重点提升模型对复杂声学环境的理解能力,并拓展至游戏开发、虚拟现实等沉浸式场景。这项技术不仅为影视音效制作、音频后期处理提供新工具,更可能重新定义人机交互中的声音体验边界。业内专家指出,ThinkSound的开源将加速音频生成领域的技术普惠,推动创作者经济向更智能的方向演进。

开源地址:

https://github.com/FunAudioLLM/ThinkSound

https://huggingface.co/spaces/FunAudioLLM/ThinkSound

https://www.modelscope.cn/studios/iic/ThinkSound