近日,阿里語音AI團隊宣佈開源全球首個支持鏈式推理的音頻生成模型ThinkSound,該模型通過引入思維鏈(Chain-of-Thought)技術,突破傳統視頻轉音頻技術對畫面動態捕捉的侷限,實現高保真、強同步的空間音頻生成。這一突破標誌着AI音頻技術從“看圖配音”向“結構化理解畫面”的跨越式發展。

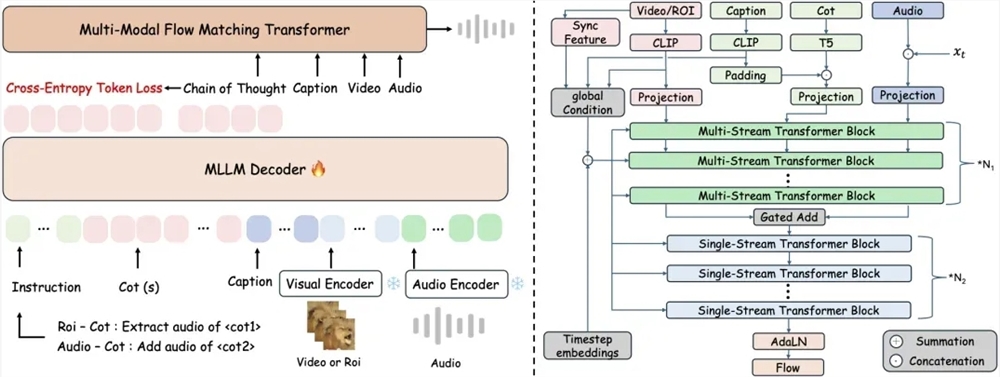

傳統端到端視頻轉音頻技術常因忽視畫面細節與聲音的時空關聯,導致生成音頻與視覺事件錯位。ThinkSound首次將多模態大語言模型與統一音頻生成架構結合,通過三階段推理機制實現精準音頻合成:系統首先解析畫面整體運動與場景語義,生成結構化推理鏈;隨後聚焦具體物體聲源區域,結合語義描述細化聲音特徵;最終支持用戶通過自然語言指令實時交互編輯,例如“在鳥鳴後添加樹葉沙沙聲”或“移除背景噪聲”。

爲支撐模型的結構化推理能力,研究團隊構建了包含2531.8小時高質量樣本的AudioCoT多模態數據集,整合VGGSound、AudioSet等來源的動物鳴叫、機械運轉等真實場景音頻。數據集通過多階段自動化過濾與人工抽樣校驗確保質量,並特別設計對象級和指令級樣本,使模型可處理“提取貓頭鷹鳴叫時避免風聲干擾”等複雜指令。

實驗數據顯示,ThinkSound在VGGSound測試集的核心指標上較主流方法提升超15%,在MovieGen Audio Bench測試集中表現大幅領先Meta同類模型。目前,該模型的代碼與預訓練權重已在GitHub、HuggingFace及魔搭社區開源,開發者可免費獲取。

阿里語音AI團隊透露,未來將重點提升模型對複雜聲學環境的理解能力,並拓展至遊戲開發、虛擬現實等沉浸式場景。這項技術不僅爲影視音效製作、音頻後期處理提供新工具,更可能重新定義人機交互中的聲音體驗邊界。業內專家指出,ThinkSound的開源將加速音頻生成領域的技術普惠,推動創作者經濟向更智能的方向演進。

開源地址:

https://github.com/FunAudioLLM/ThinkSound

https://huggingface.co/spaces/FunAudioLLM/ThinkSound

https://www.modelscope.cn/studios/iic/ThinkSound