最近、アリの音声AIチームは世界初のチェーン・オブ・ススペンス(Chain-of-Thought)をサポートする音声生成モデル「ThinkSound」をオープンソース化しました。このモデルは、思考の連鎖(Chain-of-Thought)技術を取り入れることで、従来の動画から音声への変換技術が画面の動きを捉えることの限界を突破し、高音質かつ強力な同期の空間音声生成を実現しました。この進展は、AI音声技術が「画像に音声をつける」段階から、「画像の構造的理解」への飛躍的な発展を示しています。

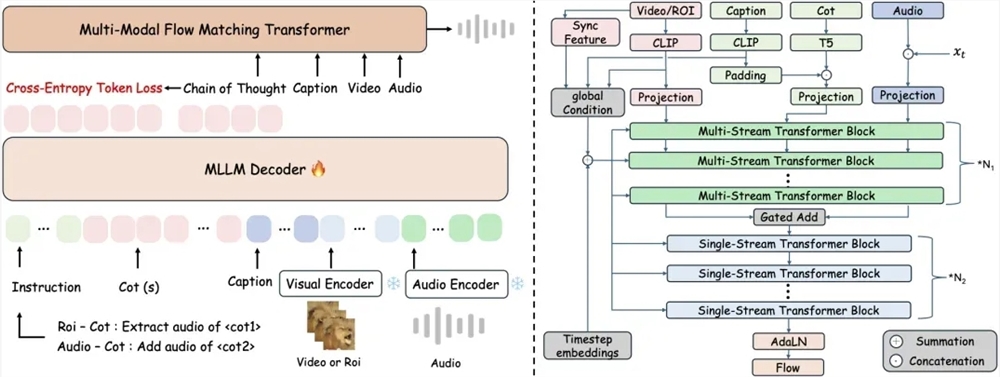

従来のエンドツーエンドの動画から音声への変換技術では、画像の詳細と音声の時空間的関係性を無視することがあり、生成された音声とビジュアルイベントがずれてしまうことがあります。ThinkSoundは、マルチモーダルの大規模言語モデルと統一的な音声生成アーキテクチャを初めて組み合わせ、正確な音声合成を実現するための3段階の推論メカニズムを採用しています。システムはまず、画像全体の動きとシーンの意味を解析し、構造化された推論チェーンを生成します。その後、具体的な物体の音源領域に焦点を当て、意味説明に基づいて音声の特徴を細かくします。最終的には、ユーザーが自然言語の指示によってリアルタイムで編集できるようにサポートし、「鳥の鳴き声の後に葉っぱのざわめきを追加する」や「背景ノイズを削除する」などの例のような指示に対応できます。

モデルの構造的推論能力を支えるために、研究チームは2531.8時間の高品質なサンプルを含むAudioCoTマルチモーダルデータセットを構築しました。このデータセットにはVGGSoundやAudioSetなどのソースからの動物の鳴き声や機械の動作などの現実的なシナリオの音声が統合されています。データセットは複数段階の自動フィルタリングと人間によるサンプリング検証を通じて品質を確保しており、特にオブジェクトレベルおよび指示レベルのサンプルが特別に設計されており、モデルが「ハトの鳴き声を抽出する際、風の音を避ける」などの複雑な指示を処理できるようにしています。

実験の結果によると、ThinkSoundはVGGSoundテストセットの主要指標において主流の方法よりも15%以上向上しており、MovieGen Audio BenchテストセットではMetaの類似モデルよりも大幅に優れています。現在、このモデルのコードと事前学習された重みはGitHub、HuggingFaceおよび魔搭コミュニティでオープンソース化されており、開発者は無料で取得できます。

アリの音声AIチームは、今後モデルが複雑な音響環境を理解する能力を重点的に向上させ、ゲーム開発や仮想現実などの没入型シナリオへ拡張する予定です。この技術は、映画の音効果制作や音声の後処理に新たなツールを提供するだけでなく、人間と機械の相互作用における音声体験の境界を再定義する可能性があります。業界の専門家は、ThinkSoundのオープンソース化が音声生成分野における技術の民主化を加速し、クリエイター経済をよりスマートな方向へ進化させるだろうと指摘しています。

オープンソースの場所:

https://github.com/FunAudioLLM/ThinkSound

https://huggingface.co/spaces/FunAudioLLM/ThinkSound

https://www.modelscope.cn/studios/iic/ThinkSound