近日,中國社交媒體公司微博的人工智能部門推出了開源的 VibeThinker-1.5B,這是一個擁有15億參數的大型語言模型(LLM)。該模型是基於阿里巴巴的 Qwen2.5-Math-1.5B 進行的精細調整,現已在 Hugging Face、GitHub 和 ModelScope 上免費提供,供研究人員和企業開發者使用,甚至可用於商業目的,遵循 MIT 許可證。

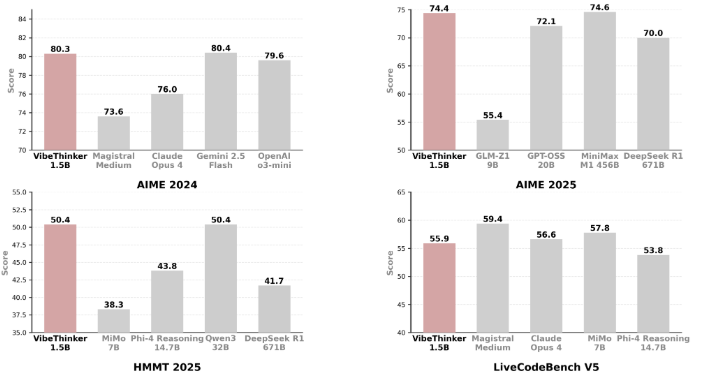

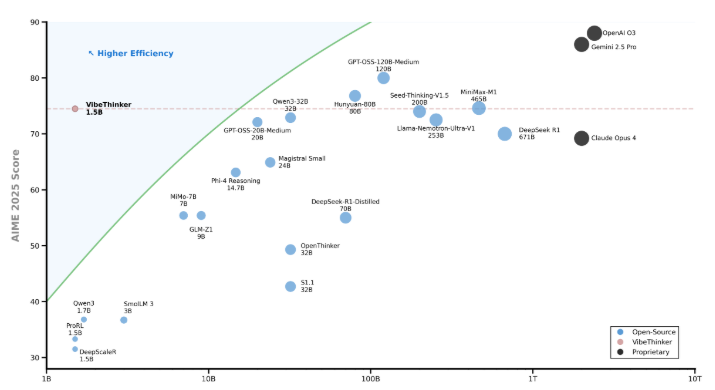

儘管 VibeThinker-1.5B 體積小,但在數學和代碼任務上表現出色,達到了行業領先的推理性能,甚至超越了體量達6710億參數的競爭對手 DeepSeek 的 R1模型。該模型還與 Mistral AI 的 Magistral Medium、Anthropic 的 Claude Opus4和 OpenAI 的 gpt-oss-20B Medium 等多個大型模型抗衡,同時所需的基礎設施和投資成本卻少得多。

值得一提的是,VibeThinker-1.5B 在後期訓練中僅花費了7800美元的計算資源,這一成本遠低於同類或更大規模模型所需的數十萬美元甚至數百萬美元。LLM 的訓練分爲兩個階段,首先是預訓練,模型通過大量文本數據學習語言結構和一般知識。之後的後期訓練則使用更小的高質量數據集,使模型能夠更好地理解如何提供幫助、進行推理和與人類期望對齊。

VibeThinker-1.5B 採用了一種名爲 “譜 - 信號原則”(Spectrum-to-Signal Principle,SSP)的訓練框架,該框架將監督微調和強化學習分爲兩個階段。第一個階段注重多樣性,第二個階段則通過強化學習優化最優路徑,使得小模型也能有效探索推理空間,從而實現信號放大。

在多個領域的性能測試中,VibeThinker-1.5B 的表現也超過了許多大型開源和商業模型。其開放源代碼的發佈,打破了對模型參數規模和計算強度的傳統看法,展示了小型模型在特定任務中也能取得優異表現的可能性。

huggingface:https://huggingface.co/WeiboAI/VibeThinker-1.5B

劃重點:

📊 VibeThinker-1.5B 是微博推出的15億參數開源 AI 模型,表現出色,甚至超越大型模型。

💰 該模型後期訓練成本僅爲7800美元,遠低於同類模型數十萬的費用。

🔍 採用 “譜 - 信號原則” 訓練框架,使小模型能夠高效推理,提升了小型模型的競爭力。