最近、中国のSNS企業であるウェイボの人工知能部門は、オープンソースのVibeThinker-1.5Bをリリースしました。これは15億パラメータを持つ大規模言語モデル(LLM)です。このモデルはアリババのQwen2.5-Math-1.5Bに基づいて微調整されており、Hugging Face、GitHub、ModelScopeで無料で公開されています。研究者や企業開発者だけでなく、商用目的にも利用可能で、MITライセンスに従います。

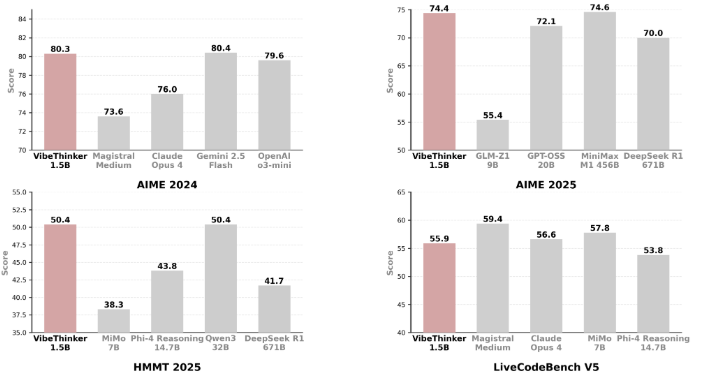

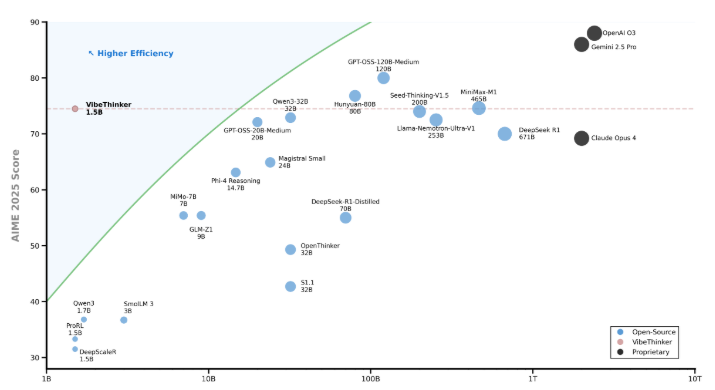

VibeThinker-1.5Bはサイズが小さいにもかかわらず、数学とコードのタスクにおいて優れた性能を示しており、業界の先進的な推論性能を持っています。これにより、パラメータ数が6710億の競合製品であるDeepSeekのR1モデルを上回る結果を出しています。また、Mistral AIのMagistral Medium、AnthropicのClaude Opus4、OpenAIのgpt-oss-20B Mediumなどの多くの大規模モデルとも対抗できる一方、必要なインフラストラクチャーや投資コストははるかに少なくて済みます。

注目すべきは、VibeThinker-1.5Bの後期トレーニングには計算リソースとして7800ドルしかかからなかったことです。これは同規模またはより大きなモデルに比べて数十万ドル乃至百万ドルかかる費用に比べて非常に低いものです。LLMのトレーニングは2段階に分かれています。最初はプレトレーニングで、モデルは大量のテキストデータを通じて言語構造や一般的な知識を学びます。その後の後期トレーニングでは、より小さな高品質なデータセットを使用し、モデルがどのように役立ち、推論を行い、人間の期待に合わせるかを理解できるようにします。

VibeThinker-1.5Bは、「スペクトル・シグナル原則」(Spectrum-to-Signal Principle、SSP)というトレーニングフレームワークを使用しています。このフレームワークでは、監督的マイクロチューニングと強化学習を2つの段階に分けます。最初の段階では多様性に重点を置き、次の段階では強化学習によって最適なパスを最適化することで、小規模モデルでも効果的に推論空間を探索し、シグナルを拡大することができます。

複数の分野での性能テストにおいて、VibeThinker-1.5Bは多くの大規模なオープンソースおよび商業モデルを上回っています。このモデルのオープンソース化により、モデルのパラメータ数や計算力に関する従来の考え方を打ち破り、特定のタスクにおいて小規模モデルでも優れた性能を発揮できる可能性を示しています。

huggingface:https://huggingface.co/WeiboAI/VibeThinker-1.5B

ポイント:

📊 VibeThinker-1.5Bは、ウェイボがリリースした15億パラメータのオープンソースAIモデルであり、性能が優れ、大型モデルを上回っています。

💰 後期トレーニングコストはわずか7800ドルで、他のモデルに比べて数十万ドルの費用よりもはるかに安いです。

🔍 「スペクトル・シグナル原則」によるトレーニングフレームワークを採用し、小規模モデルでも効率的な推論が可能になり、小規模モデルの競争力を高めています。