阿里巴巴自然語言處理團隊宣佈推出WebWatcher,這是一個開源的多模態深度研究智能體,旨在突破現有閉源系統和開源Agent在多模態深度研究領域的侷限性。WebWatcher通過整合網頁瀏覽、圖像搜索、代碼解釋器和內部OCR等多種工具,能夠像人類研究員一樣處理複雜的多模態任務,展現出強大的視覺理解、邏輯推理、知識調用、工具調度和自我驗證能力。

WebWatcher的開發團隊指出,儘管現有的閉源系統如OpenAI的DeepResearch在文本深度研究方面表現出色,但它們大多侷限於純文本環境,難以處理現實世界中複雜的圖像、圖表和混合內容。而現有的開源Agent也面臨兩大瓶頸:一類是專注於文本檢索的Agent,雖然能夠整合信息,但無法處理圖像;另一類是視覺Agent,雖然能夠識別圖像,但缺乏跨模態推理和多工具協同能力。WebWatcher正是爲了解決這些瓶頸而設計的。

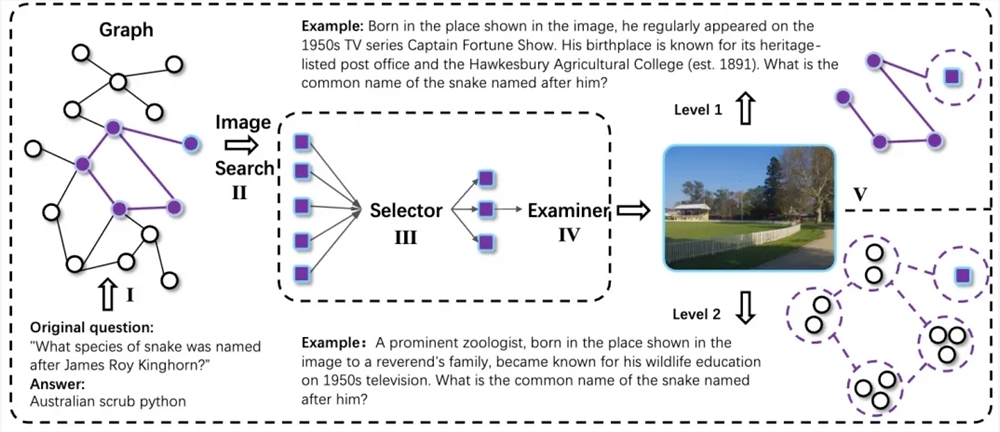

WebWatcher的技術方案覆蓋了從數據構建到訓練優化的完整鏈路,其核心目標是讓多模態Agent在高難度多模態深度研究任務中具備靈活推理和多工具協作能力。爲此,研究團隊設計了一個全自動多模態數據生成流程,通過隨機遊走收集跨模態知識鏈,並引入信息模糊化技術,提升任務的不確定性和複雜性。所有複雜問題樣本通過QA-to-VQA轉換模塊擴展爲多模態版本,進一步增強了模型的跨模態理解能力。

在高質量推理軌跡構建與後訓練方面,WebWatcher採用了Action-Observation驅動的軌跡生成方法,通過收集真實的多工具交互軌跡並進行監督微調(SFT),讓模型在訓練初期快速掌握多模態ReAct式推理和工具調用的基本模式。隨後,模型進入強化學習階段,通過GRPO進一步提升多模態Agent在複雜環境下的決策能力。

爲了全面驗證WebWatcher的能力,研究團隊提出了BrowseComp-VL,這是BrowseComp在視覺-語言任務上的擴展版本,旨在逼近人類專家的跨模態研究任務難度。在多輪嚴格評測中,WebWatcher在複雜推理、信息檢索、知識整合以及聚合類信息尋優等任務上全面領先於當前主流的開源與閉源多模態大模型。

具體來說,在人類終極考試(Humanity’s Last Exam,HLE-VL)這一多步複雜推理基準上,WebWatcher以13.6%的Pass@1分數一舉奪魁,大幅領先於GPT-4o(9.8%)、Gemini2.5-flash(9.2%)和Qwen2.5-VL-72B(8.6%)等代表性模型。在更貼近真實多模態搜索的MMSearch評測中,WebWatcher的Pass@1得分高達55.3%,相比Gemini2.5-flash(43.9%)和GPT-4o(24.1%)大幅領先。在LiveVQA評測中,WebWatcher的Pass@1成績達到58.7%,領先於其他主流模型。在最具綜合挑戰的BrowseComp-VL基準上,WebWatcher以27.0%的平均得分(Pass@1)遙遙領先,成績提升超過一倍。

倉庫地址:https://github.com/Alibaba-NLP/WebAgent