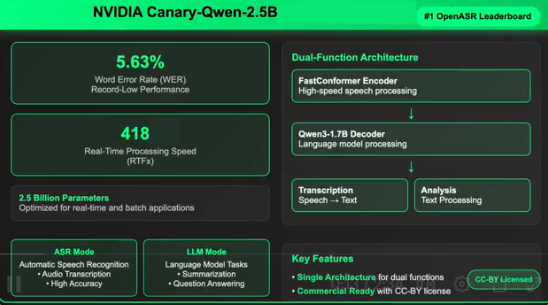

NVIDIA剛剛發佈了Canary-Qwen-2.5B,這是一款突破性的自動語音識別(ASR)和語言模型(LLM)混合模型,以創紀錄的5.63%詞錯率(WER)榮登Hugging Face OpenASR排行榜榜首。該模型獲得CC-BY許可,具有商業許可和開源特性,爲企業級語音AI發展掃清了障礙。

技術突破:統一語音理解與語言處理

此次發佈標誌着重要的技術里程碑,Canary-Qwen-2.5B將轉錄和語言理解統一到單一模型架構中,支持直接從音頻執行摘要和問答等下游任務。這種創新架構徹底改變了傳統ASR流程,將轉錄和後處理從獨立階段整合爲統一工作流程。

關鍵性能指標

該模型在多個維度創下新紀錄:

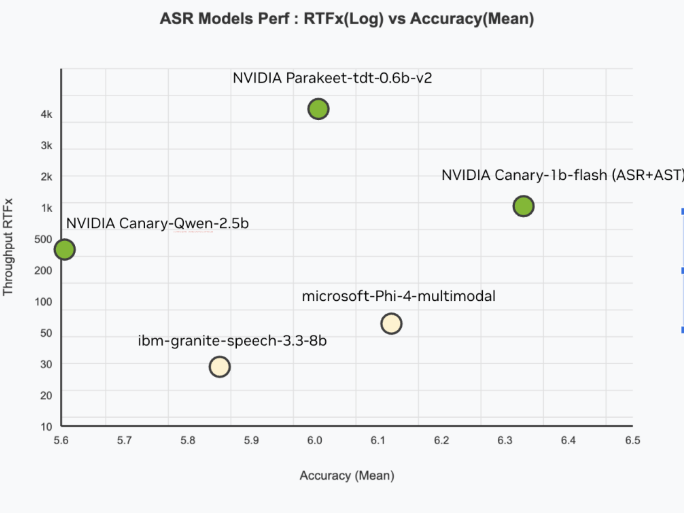

- 準確性:5.63% WER,Hugging Face OpenASR排行榜最低

- 速度:RTFx爲418,可比實時速度快418倍處理音頻

- 效率:僅25億參數,相比性能較差的大型模型更爲緊湊

- 訓練規模:基於234,000小時多樣化英語語音數據集

創新混合架構設計

Canary-Qwen-2.5B的核心創新在於其混合架構,包含兩個關鍵組件:

FastConformer編碼器專門用於低延遲和高精度轉錄,而Qwen3-1.7B LLM解碼器則是未經修改的預訓練大型語言模型,通過適配器接收音頻轉錄標記。

這種適配器設計確保了模塊化,允許Canary編碼器分離,並將Qwen3-1.7B作爲獨立LLM運行用於基於文本的任務。單一部署即可處理口語和書面輸入的下游語言任務,提升了多模態靈活性。

企業級應用價值

與許多受非商業許可約束的研究模型不同,Canary-Qwen-2.5B採用CC-BY許可發佈,開啓了廣泛的商業應用場景:

- 企業轉錄服務

- 基於音頻的知識提取

- 實時會議總結

- 語音控制的AI代理

- 符合法規要求的文檔處理(醫療保健、法律、金融)

該模型的LLM感知解碼功能還提升了標點符號、大寫字母和上下文準確度,這些往往是傳統ASR輸出的薄弱環節。

硬件兼容性與部署靈活性

Canary-Qwen-2.5B針對多種NVIDIA GPU進行了優化,支持從數據中心的A100、H100到工作站RTX PRO6000,再到消費級GeForce RTX5090等硬件。這種跨硬件類別的擴展性使其適用於雲推理和內部邊緣工作負載。

開源推動行業發展

通過開源該模型及其訓練方案,NVIDIA研究團隊旨在促進社區驅動的語音AI進步。開發者可以混合搭配其他兼容NeMo的編碼器和LLM,爲新領域或語言創建特定任務的混合模型。

該版本還爲以LLM爲中心的ASR開創了先河,其中LLM不再是後處理器,而是集成在語音轉文本流程中的核心代理。這種方法反映了向代理模型邁進的更廣闊趨勢——能夠基於現實世界多模態輸入進行全面理解和決策的系統。

NVIDIA的Canary-Qwen-2.5B不僅僅是一個ASR模型,更是將語音理解與通用語言模型相集成的藍圖。憑藉SoTA性能、商業可用性以及開放的創新途徑,該版本有望成爲企業、開發者和研究人員解鎖下一代語音優先AI應用的基礎工具。

地址:https://huggingface.co/nvidia/canary-qwen-2.5b