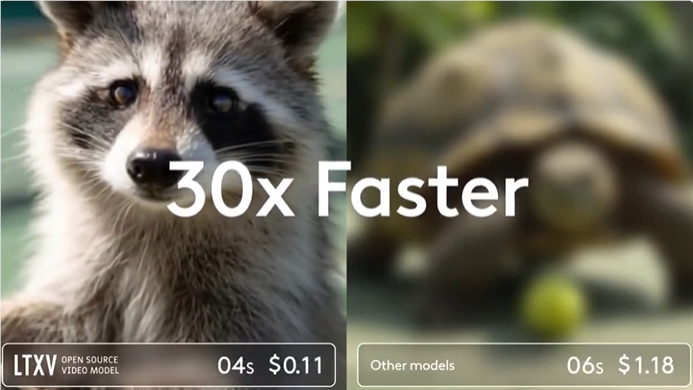

人工智能視頻生成技術再迎重大突破!Lightricks旗下LTX Studio近日發佈了其最新開源視頻生成模型LTX-Video13B,憑藉130億參數、30倍於同類模型的生成速度以及創新的多尺度渲染技術,迅速成爲行業焦點。該模型不僅在消費級GPU上實現高效運行,還顯著提升了視頻的連貫性與細節表現,爲創作者提供了前所未有的控制力與靈活性。

技術突破:多尺度渲染重塑視頻生成

LTX-Video13B採用獨特的多尺度渲染技術,通過先以低分辨率生成視頻的粗略運動和場景佈局,再逐步細化細節的創新方法,顯著提升了生成速度與畫質。該技術使模型在保持高質量輸出的同時,生成速度比同類模型快30倍,渲染5秒視頻僅需2秒,且能在如NVIDIA RTX4090的消費級GPU上流暢運行。相比傳統模型,其內存需求更低,爲創作者提供了更高效的創作體驗。

模型基於DiT(Diffusion Transformer)架構,結合先進的內核優化和bfloat16數據格式,進一步提升了性能。LTX-Video13B支持1216×704分辨率、30幀/秒的實時生成,適用於文本到視頻、圖像到視頻以及視頻到視頻等多種生成模式,滿足多樣化的創作需求。

強大功能:精準控制與無限創意

LTX-Video13B在動作連貫性、場景結構和鏡頭關係理解方面表現出色,能夠生成邏輯性強、細節豐富的視頻內容。模型支持關鍵幀控制、角色與鏡頭運動以及多鏡頭組合,爲用戶提供細粒度的創作控制。例如,創作者可以通過文本提示或參考圖像精確調整視頻中的角色動作、場景切換或鏡頭角度,實現電影般的視覺效果。

此外,LTX-Video13B支持視頻延展和風格/動作替換功能,用戶可將現有視頻延長至最長60秒,或對視頻進行風格化處理,如將現實場景轉換爲動畫風格。這種靈活性使其在短片製作、廣告創意和社交媒體內容創作中具有廣泛應用潛力。

開源生態:賦能開發者與創作者

作爲開源模型,LTX-Video13B在GitHub和Hugging Face上免費提供,允許開發者與創作者自由修改和定製。Lightricks還提供了LTX-Video-Trainer工具,支持2B和13B模型的完整微調以及LoRA(低秩適配)訓練,方便用戶開發定製化的控制模型,如深度、姿勢或邊緣檢測等。模型兼容ComfyUI工作流,新增的Looping Sampler節點支持生成任意長度的視頻,確保運動一致性。

爲進一步降低使用門檻,Lightricks發佈了一系列輔助工具,包括8位量化版本(ltxv-13b-fp8)和IC-LoRA Detailer,優化了在低內存設備上的運行性能。模型對初創企業和年收入低於1000萬美元的組織免費開放,體現了Lightricks推動AI民主化的承諾。

視頻生成的新里程碑

AIbase認爲,LTX-Video13B的發佈標誌着開源視頻生成技術邁向新高度。其多尺度渲染技術和對消費級硬件的優化,打破了傳統AI視頻生成對高性能設備的需求,爲中小型團隊和個人創作者提供了專業級的創作工具。結合開源社區的協作,LTX-Video13B有望推動視頻生成技術的進一步創新,廣泛應用於影視、遊戲、廣告和教育等領域。

目前,LTX-Video13B已集成至LTX Studio平臺,用戶可通過官方網站(https://ltx.studio)或GitHub(https://github.com/Lightricks/LTX-Video)獲取模型及文檔。Lightricks還計劃持續優化模型,支持更多控制類型和多模態功能,爲創作者提供更強大的工具。

未來展望:開啓AI視頻創作新篇章

Lightricks表示,LTX-Video13B的開發得益於與Getty Images等合作伙伴提供的高質量數據集,確保了輸出內容的商業安全性和視覺吸引力。未來,團隊將進一步探索時間變化提示和多模態生成,以支持更復雜的創作需求。AIbase期待LTX-Video13B在開源社區的推動下,成爲AI視頻生成領域的標杆。

試用:https://app.ltx.studio/gen-workspace

模型下載:https://ltxv.video/#get-started