在深度學習的領域,循環神經網絡(RNN)和 Transformer 模型各有千秋。近期研究發現,線性循環模型(如 Mamba)憑藉其優越的序列處理能力,正在逐漸挑戰 Transformer 的地位。尤其是在處理極長序列的任務上,循環模型展現出了巨大的潛力,遠遠超出傳統 Transformer 模型的侷限性。

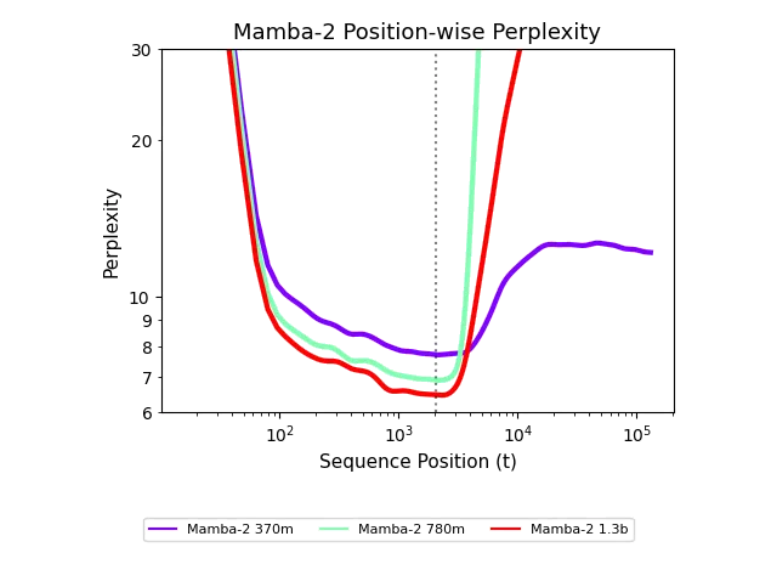

Transformer 模型在處理長上下文時,往往受到固定上下文窗口的限制,計算複雜度也隨着序列長度的增加而迅速上升,導致性能下降。而線性循環模型則能夠更靈活地處理長序列,這是它們的一大優勢。然而,以往循環模型在短序列上的表現往往不及 Transformer,導致其在實際應用中受到限制。

最近,來自卡內基梅隆大學和 Cartesia AI 的研究者們提出了一種創新的方法來提升循環模型在長序列上的泛化能力。他們發現,只需500步的簡單訓練干預,循環模型便能夠處理長達256k 的序列,展現出驚人的泛化能力。這項研究表明,循環模型並非存在根本缺陷,而是其潛力尚未被充分挖掘。

研究團隊提出了一個新的解釋框架,稱爲 “未探索狀態假說”。該假說指出,循環模型在訓練過程中只接觸到有限的狀態分佈,導致在面對更長序列時表現不佳。爲了實現長度泛化,研究者們提出了一系列訓練干預措施,包括使用隨機噪聲、擬合噪聲和狀態傳遞等方法。這些措施使得模型能夠在長序列的訓練中有效泛化,表現顯著提升。

值得一提的是,這些干預方法不僅能提升模型的性能,還能保持狀態的穩定性,使得循環模型在長上下文任務中表現出色。研究者們通過一系列實驗,證明了這些方法在實際應用中的有效性,爲循環模型的發展開闢了新的方向。