ディープラーニングの分野において、循環ニューラルネットワーク(RNN)とTransformerモデルはそれぞれ長所を持っています。最近の研究では、線形循環モデル(例えばMamba)が優れたシーケンス処理能力を備え、Transformerの地位に挑戦しつつあることが明らかになりました。特に極めて長いシーケンスのタスクにおいて、循環モデルは従来のTransformerモデルの限界をはるかに超える大きな潜在力を示しています。

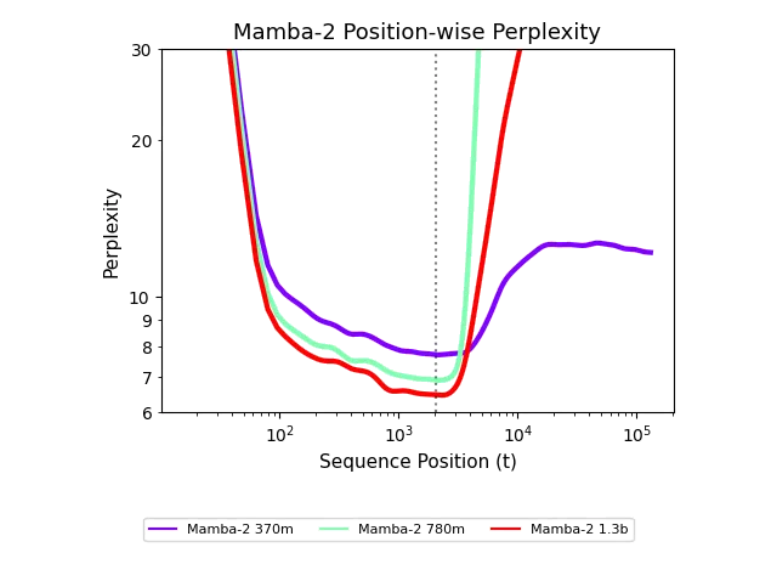

Transformerモデルは、長文脈を処理する際には固定された文脈ウィンドウの制限に直面し、シーケンスの長さが増すにつれて計算複雑度が急速に上昇し、結果として性能が低下します。一方、線形循環モデルはより柔軟に長いシーケンスを処理できることから、これは大きな利点です。しかし、これまでの循環モデルは短いシーケンスにおいてはTransformerに劣ることが多く、実際の応用において制限を受けていました。

最近、カーネギーメロン大学およびCartesia AIの研究者たちは、循環モデルの長さに対する一般化能力を向上させるための革新的な方法を提案しました。彼らは、わずか500ステップの単純なトレーニング介入で、循環モデルが最大256kのシーケンスを処理できることがわかりました。これは驚くべき一般化能力であり、循環モデルが根本的な欠陥を持っているわけではなく、その潜在力がまだ十分に引き出されていないことを示しています。

研究チームは、「未探索状態仮説」と呼ばれる新しい解釈フレームワークを提案しました。この仮説によると、循環モデルはトレーニング中に限られた状態分布しか見ないため、より長いシーケンスに対しては性能が悪くなるのです。長さの一般化を実現するために、研究者たちはランダムノイズの使用、ノイズのフィッティング、状態の伝達などのトレーニング介入策を提案しました。これらの対策により、モデルは長く続くシーケンスのトレーニングにおいて効果的に一般化でき、性能が著しく向上しました。