在人工智能迅速發展的時代,大型模型的智能化水平不斷提升,但隨之而來的推理系統效率挑戰也越來越明顯。如何應對高推理負載、降低推理成本、縮短響應時間,已成爲業界共同面對的重要問題。

Kimi 公司聯合清華大學的 MADSys 實驗室,推出了基於 KVCache 的 Mooncake 推理系統設計方案,該方案於2024年6月正式發佈。

Mooncake 推理系統通過創新的 PD 分離架構和以存換算爲中心的理念,顯著提升了推理的吞吐能力,吸引了廣泛的行業關注。爲了進一步推動這一技術框架的應用與普及,Kimi 與清華大學 MADSys 實驗室聯合多家企業,如9#AISoft、阿里雲、華爲存儲等,推出了開源項目 Mooncake。11月28日,Mooncake 的技術框架在 GitHub 平臺正式上線。

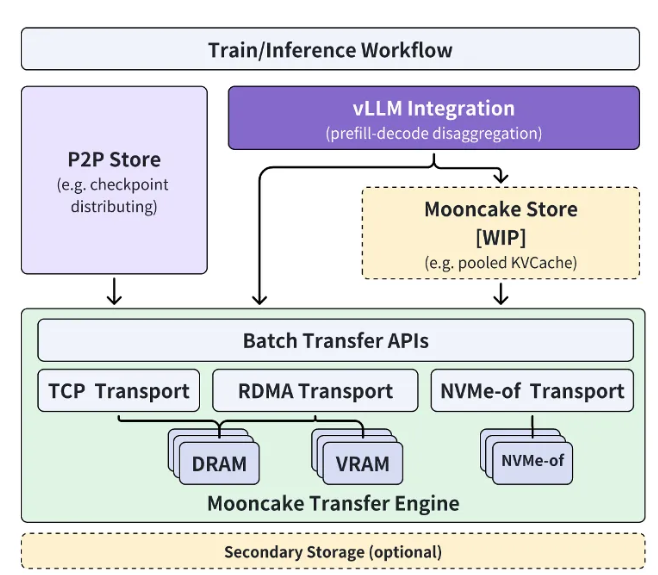

Mooncake 開源項目圍繞超大規模 KVCache 緩存池展開,致力於通過分階段的方式逐步開源高性能的 KVCache 多級緩存 Mooncake Store。同時,該項目將兼容多種推理引擎和底層存儲、傳輸資源。

目前,傳輸引擎 Transfer Engine 的部分已經在 GitHub 上全球開源。Mooncake 項目的終極目標是爲大模型時代構建一個新型高性能內存語義存儲的標準接口,並提供相關的參考實現方案。

Kimi 公司的工程副總裁許欣然表示:“通過與清華大學 MADSys 實驗室的緊密合作,我們共同打造了分離式的大模型推理架構 Mooncake,實現了推理資源的極致優化。

Mooncake 不僅提升了用戶體驗,還降低了成本,爲處理長文本和高併發需求提供了有效解決方案。” 他期待更多企業和研究機構加入 Mooncake 項目,共同探索更高效的模型推理系統架構,讓 AI 助手等基於大模型技術的產品能夠惠及更廣泛的人羣。

項目入口:https://github.com/kvcache-ai/Mooncake

劃重點:

🌟 Kimi 與清華大學聯合發佈 Mooncake 推理系統,提升 AI 推理效率。

🔧 Mooncake 項目已在 GitHub 上開源,旨在構建高性能內存語義存儲標準接口。

🤝 期待更多企業和研究機構參與,共同推動 AI 技術進步。