最近,NVIDIA 聯合 Georgia Tech、UMD 和 HKPU 的研究團隊推出了全新的視覺語言模型 ——NVEagle。它能看懂圖片還能跟你聊天,這相當於一個會看會說的超級助手。

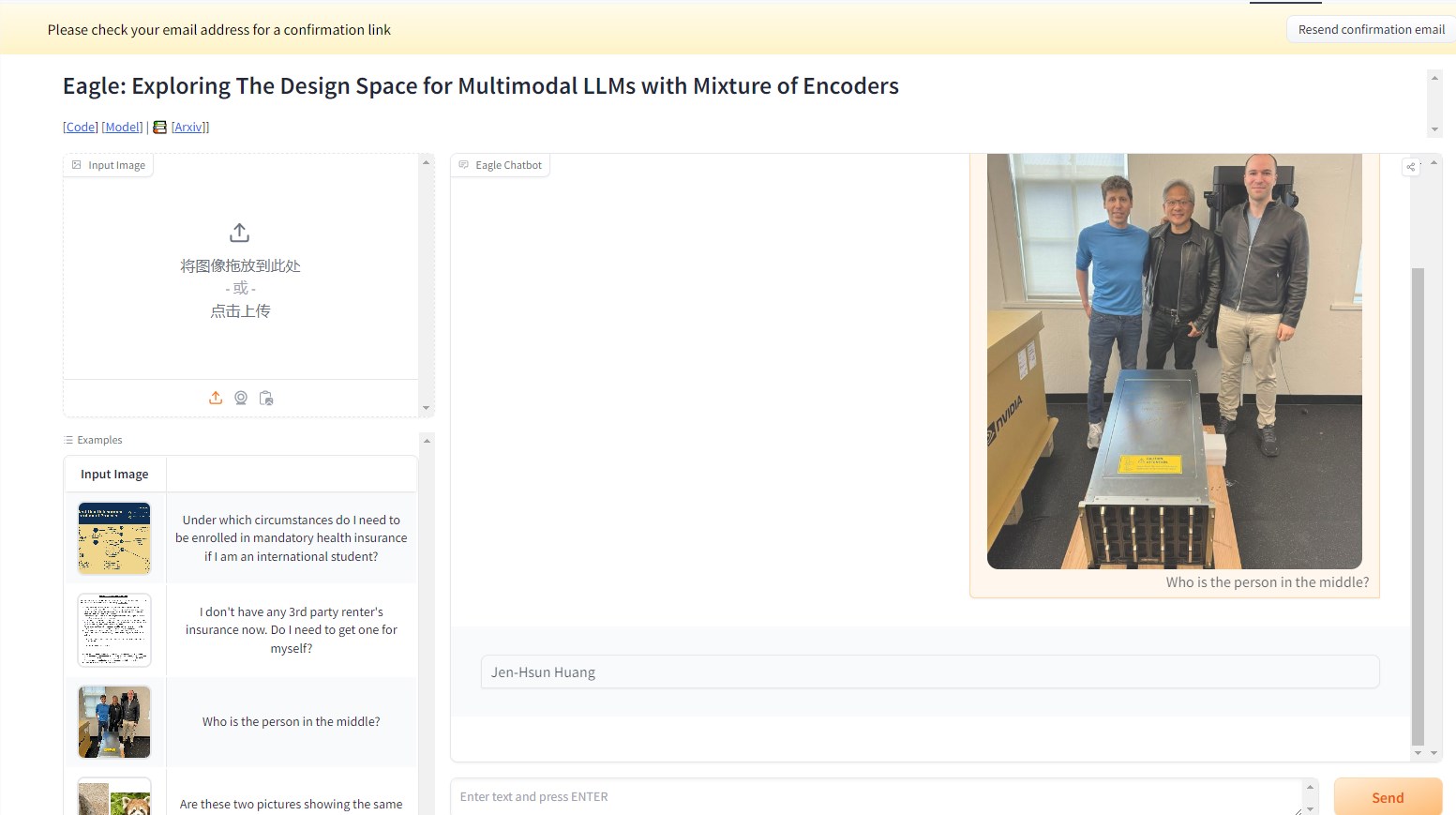

比如在下面的實例中,向NVEagle模型詢問圖片中的人物是誰?模型就能對圖片進行解讀,給出回覆的答案是:黃仁勳。相當精準。

這個多模態的大型語言模型(MLLM)在視覺和語言信息的結合上,邁出了重要一步。NVEagle 能夠理解複雜的現實場景,通過視覺輸入進行更好的解讀和迴應。它的設計核心在於將圖像轉化爲視覺標記,再與文本嵌入相結合,進而提升了對視覺信息的理解。

然而,構建這樣一個強大的模型也面臨着不少挑戰,尤其是在視覺感知能力的提升方面。研究表明,許多現有模型在處理高分辨率圖像時,會出現 “幻覺” 現象,也就是生成不準確或無意義的輸出。這在需要細緻分析的任務中尤爲明顯,比如光學字符識別(OCR)和文檔理解。爲了克服這些困難,研究團隊進行了多種方法的探索,包括測試不同的視覺編碼器和融合策略。

NVEagle 的推出是這一研究的成果,具體包括了三個版本:Eagle-X5-7B、Eagle-X5-13B 以及 Eagle-X5-13B-Chat。其中,7B 和13B 版本主要用於一般的視覺語言任務,而13B-Chat 版本則專門針對對話式 AI 進行了微調,能夠更好地進行基於視覺輸入的互動。

NVEagle 的一個亮點在於採用了混合專家(MoE)機制,能夠根據不同任務動態選擇最合適的視覺編碼器,這極大提升了對複雜視覺信息的處理能力。該模型已在 Hugging Face 上發佈,方便研究人員和開發者使用。

在各種基準測試中,Eagle 模型的表現相當出色。例如,在 OCR 任務中,Eagle 模型在 OCRBench 上獲得了85.9的平均分,超過了 InternVL 和 LLaVA-HR 等其他領先模型。而在 TextVQA 測試中,它的得分達到了88.8,在複雜的視覺問答任務中也表現不俗,GQA 測試得分爲65.7。此外,模型在增加額外視覺專家的情況下,表現也持續提升。

NVEagle 系列模型通過系統化的設計探索和優化,成功解決了視覺感知中的多項關鍵挑戰,爲視覺語言模型的發展開闢了新天地。

項目入口:https://top.aibase.com/tool/eagle

demo:https://huggingface.co/spaces/NVEagle/Eagle-X5-13B-Chat

劃重點:

🌟 NVEagle 是 NVIDIA 推出的新一代視覺語言模型,旨在提高對複雜視覺信息的理解。

📈 模型包含三個版本,分別適用於不同的任務,其中13B-Chat 版本專注於對話式 AI。

🏆 在多個基準測試中,Eagle 模型的表現優於現有許多領先模型,展現出卓越的性能。