近日,開源社區迎來了 LLaVA-OneVision-1.5,這是一款全新的多模態模型,標誌着技術的一次重大進步。LLaVA(大型語言與視覺助手)系列歷經兩年開發,逐步從簡單的圖文對齊模型演變爲能夠處理圖像、視頻等多種輸入形式的綜合性框架。

LLaVA-OneVision-1.5的核心理念是提供一個開放、高效且可復現的訓練框架,讓用戶能夠輕鬆構建高質量的視覺語言模型。其訓練過程分爲三個階段:首先,通過語言 - 圖像對齊的預訓練階段,模型學習將視覺特徵轉化爲語言詞嵌入。

接着,在第二階段 “高質量知識學習” 中,模型在8500萬的訓練樣本上進行全參數訓練,注入大量視覺和知識信息,顯著提升模型能力。最後,在視覺指令微調階段,使用精心設計的數據集進行訓練,使模型具備處理多種複雜視覺指令的能力。

在效率方面,團隊採用了一種創新的離線並行數據打包方法,顯著提高了訓練效率。在8500萬樣本的基礎上,數據處理的壓縮比高達11倍,訓練過程僅需3.7天便可完成。同時,LLaVA-OneVision-1.5還採用了 RICE-ViT 作爲視覺編碼器,具備區域感知的視覺理解能力,特別適合處理文檔中的文字。

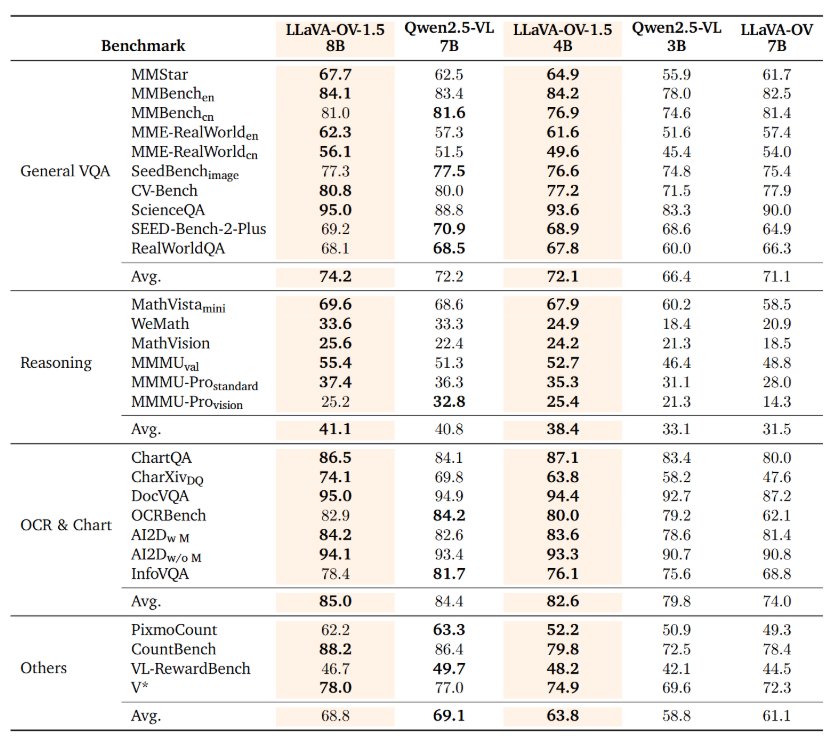

數據是模型能力的基礎,LLaVA-OneVision-1.5的預訓練數據集廣泛多樣,並引入了 “概念均衡” 的採樣策略,確保模型在各類任務上的表現均衡。該模型在各項基準測試中表現出色,尤其是80億參數的版本在27個基準中超越了 Qwen2.5-VL 的表現。

項目:

https://github.com/EvolvingLMMs-Lab/LLaVA-OneVision-1.5

https://huggingface.co/lmms-lab/LLaVA-OneVision-1.5-8B-Instruct

劃重點:

🌟 LLaVA-OneVision-1.5是最新的開源多模態模型,具有處理圖像和視頻等多種輸入的能力。

📈 訓練過程分爲三個階段,旨在高效提升模型的視覺與語言理解能力。

🏆 在基準測試中,LLaVA-OneVision-1.5表現優異,超越了 Qwen2.5-VL 模型。