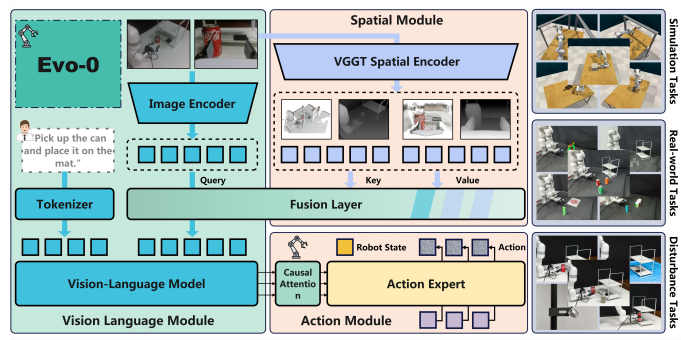

在機器人領域,讓人工智能真正 “看懂” 三維世界一直是一個棘手的問題。傳統的視覺語言模型(VLA)大多依賴於二維圖像和文本數據訓練,難以理解真實環境中的三維空間。然而,最近來自上海交通大學和劍橋大學的研究團隊提出了一種名爲 Evo-0的新型增強視覺語言動作模型,通過輕量化的方式注入3D 幾何先驗,使得機器人在複雜任務中的空間理解能力得到了顯著提升。

Evo-0模型的創新在於其利用視覺幾何基礎模型(VGGT),從多視角的 RGB 圖像中提取出三維結構信息,並將這些信息與已有的視覺語言模型相結合。這種方法不僅避免了使用額外傳感器或顯式深度輸入的需要,還顯著提升了空間感知能力。在 RLBench 仿真實驗中,Evo-0在五個需要精細操作的任務上,成功率比基線模型 pi0高出15%,並且在開放 VLA(openvla-oft)上提升了31%。

具體而言,Evo-0將 VGGT 作爲空間編碼器,引入了通過 VGGT 提取的 t3^D token,這些 token 包含了深度上下文和空間關係等幾何信息。通過交叉注意力融合模塊,模型能夠將提取的二維視覺 token 與三維 token 進行有效結合,提升了對空間佈局和物體關係的理解能力。這種方法在保證訓練效率的同時,靈活性和部署便捷性也得到了提高。

在真實世界的實驗中,Evo-0在處理複雜空間任務時表現出色,包括目標居中放置、插孔、密集抓取等任務,均超過了基線模型,平均成功率提升了28.88%。特別是在對複雜空間關係的理解和操控能力方面,Evo-0展現出顯著優勢。

綜上所述,Evo-0通過巧妙的空間信息融合,爲未來的通用機器人策略提供了一條新的可行路徑。該研究成果不僅在學術界引發了廣泛關注,也爲機器人領域的實際應用帶來了新的可能性。

論文地址:https://arxiv.org/pdf/2507.00416