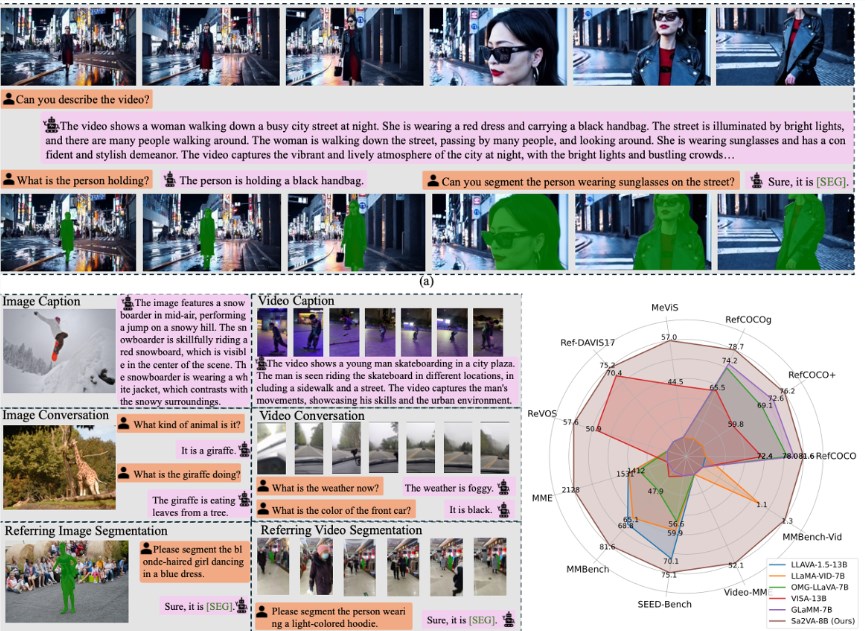

在近期的 AI 技術進展中,字節跳動與多所高校的研究團隊合作,將先進的視覺語言模型 LLaVA 與分割模型 SAM-2結合,推出了名爲 Sa2VA 的新模型。這一創新模型不僅能夠理解視頻內容,還可以根據用戶指令精確追蹤和分割視頻中的角色和物體。

LLaVA 作爲一種開源視覺語言模型,擅長於視頻的宏觀敘事和內容理解,但在細節指示方面則顯得力不從心。而 SAM-2則是一種出色的圖像分割專家,能夠識別和分割圖像中的物體,但缺乏語言理解能力。爲了彌補彼此的不足,Sa2VA 通過一個簡單而高效的 “暗號” 系統,將這兩種模型有效結合。

Sa2VA 的架構可以被視作一個雙核處理器:一核負責語言理解與對話,另一核負責視頻分割與跟蹤。當用戶輸入指令時,Sa2VA 生成特定的指令 token,傳遞給 SAM-2以進行具體的分割操作。通過這一設計,兩個模塊在各自領域內發揮專長,並能進行有效的反饋學習,進而不斷提升整體性能。

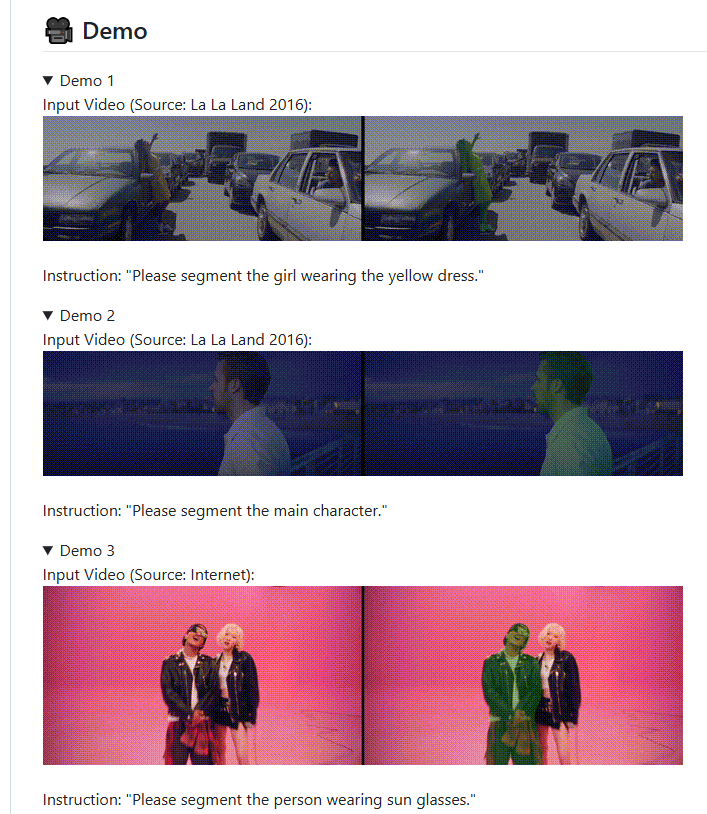

研究團隊還爲 Sa2VA 設計了多任務聯合訓練課程,以增強其在圖像和視頻理解方面的能力。在多項公開測試中,Sa2VA 展現了出色的性能,尤其在視頻指代表達分割任務中表現尤爲亮眼。它不僅能在複雜的真實場景中實現精準的分割,還能在視頻中實時跟蹤目標對象,顯示出強大的動態處理能力。

此外,字節跳動還開放了 Sa2VA 的多種版本和訓練工具,鼓勵開發者進行研究和應用。這一舉措爲 AI 領域的研究人員和開發者提供了豐富的資源,推動了多模態 AI 技術的發展。

項目:

https://lxtgh.github.io/project/sa2va/

https://github.com/bytedance/Sa2VA

劃重點:

- 🎥 Sa2VA 是字節跳動推出的新模型,結合了 LLaVA 與 SAM-2的優點,實現了視頻內容的理解與分割。

- 🔗 該模型通過 “暗號” 系統有效連接語言理解與圖像分割,提升了交互能力。

- 🌍 Sa2VA 的開放資源爲開發者提供了豐富的工具,促進了多模態 AI 技術的研究與應用。