AMDはIBMとAIスタートアップのZyphraと協力して、ZAYA1を発表しました。これは世界初の全プロセスがAMDハードウェアで訓練されたMoEベースモデルであり、14Tトークンの事前学習を行い、総合的な性能はQwen3シリーズと同等です。Qwen3プロフェッショナル版に指示微調整を行わずに数学/STEM推論に近づいています。

トレーニング規模

- クラスター: IBM Cloud 128ノード×8枚のAMD Instinct MI300X、計1024枚; InfinityFabric+ROCm、ピーク750PFLOPs

- データ: 14Tトークン、コース学習は一般的なウェブページ→数学/コード/推論へと進化します。後続のバージョンは別途リリースされます。

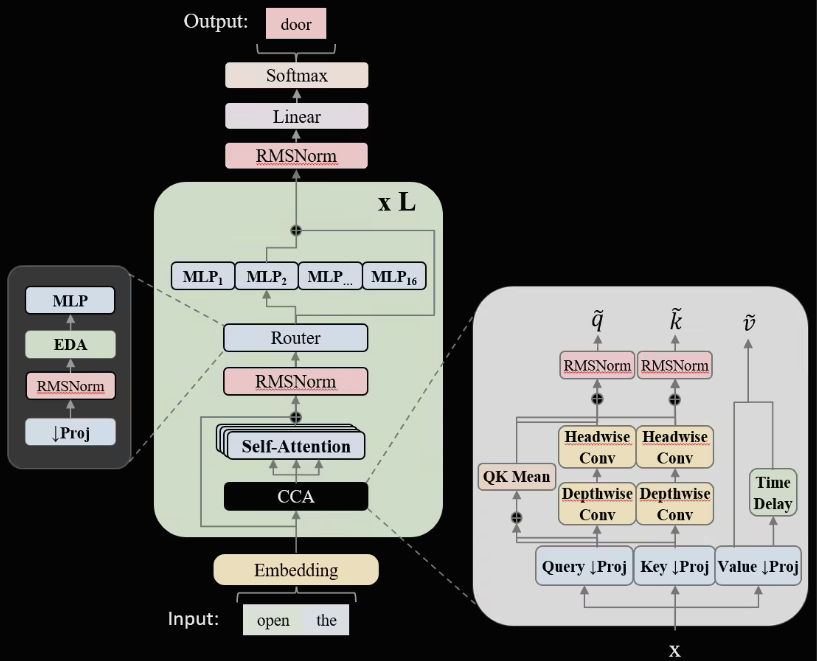

アーキテクチャのイノベーション

1. CCAアテンション: 畳み込み+圧縮埋め込みアテンションヘッド、メモリ使用量は32%減少し、長文の処理速度は18%向上しています。

2. ラインアラウトMoE: 専門家粒度の細分化と負荷バランス正則化により、Top-2ルーティング精度は2.3pp向上し、70%のスパース性でも高い利用率を維持しています。

ベンチマーク成績

ZAYA1-Base(インストラクションなし)はMMLU-Redux、GSM-8K、MATH、ScienceQAなどのベンチマークでQwen3-Baseと同等の結果を示します。CMATHとOCW-Mathでは顕著に上回り、STEMの潜在能力を証明しています。Zyphraは、インストラクションとRLHFバージョンは2026年第1四半期にリリースされ、APIと重みのダウンロードが公開される予定であると明らかにしています。