AMD攜手IBM與AI初創Zyphra發佈ZAYA1——全球首個全程基於AMD硬件訓練的MoE基礎模型,預訓練14T tokens,綜合性能與Qwen3系列持平,數學/STEM推理未經指令微調即可逼近Qwen3專業版。

訓練規模

- 集羣:IBM Cloud128節點×8張AMD Instinct MI300X,共1024卡;InfinityFabric+ROCm,峯值750PFLOPs

- 數據:14T tokens,課程學習由通用網頁→數學/代碼/推理;後訓練版本將另行發佈

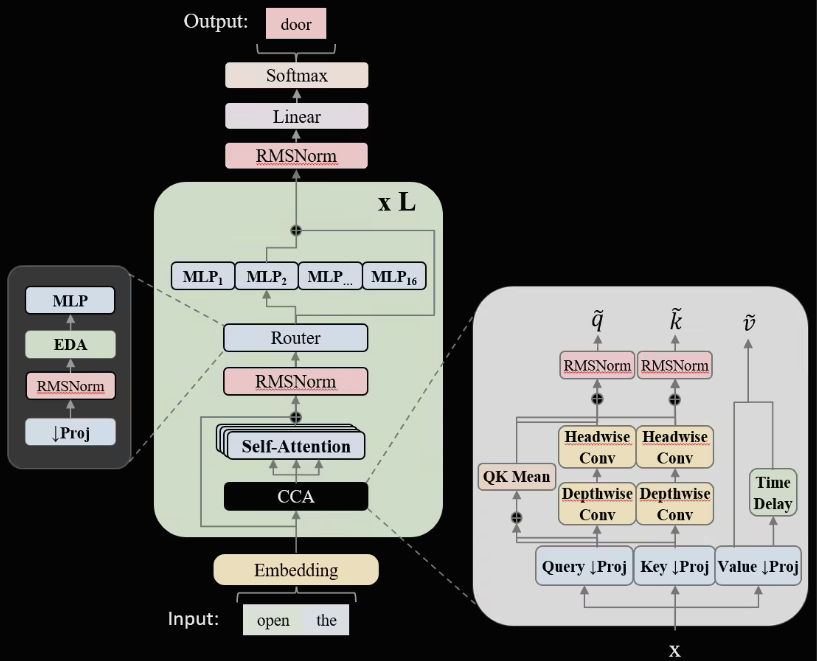

架構創新

1. CCA注意力:卷積+壓縮嵌入注意力頭,顯存佔用↓32%,長上下文吞吐↑18%

2. 線性路由MoE:專家粒度細化+負載均衡正則,Top-2路由精度提升2.3pp,稀疏度達70%時仍保持高利用率

基準成績

ZAYA1-Base(非指令版)在MMLU-Redux、GSM-8K、MATH、ScienceQA等基準與Qwen3-Base打平;CMATH與OCW-Math顯著超越,驗證STEM潛力。Zyphra透露,指令與RLHF版本將於2026Q1推出,並開放API與權重下載。

AMD表示,此次合作驗證MI300X+ROCm在大規模MoE訓練中的可行性,未來將與更多雲廠商複製“純AMD”集羣方案,目標2026年訓練>100B參數的MoE模型時實現與NVIDIA方案TCO持平。