小紅書 Hi Lab は最近、自社開発の最初のマルチモーダル大規模モデル dots.vlm1 をリリースし、オープンソース化しました。このモデルは、120億パラメータの NaViT ビジュアルエンコーダー と DeepSeek V3 大規模言語モデル をもとに、ゼロから完全にトレーニングされており、マルチモーダル視覚理解と推論能力において現在のトップクラスの閉鎖型モデル、例えば Gemini2.5Pro と Seed-VL1.5 に近づいており、オープンソースのマルチモーダルモデルの性能が新たな高みに達したことを示しています。

自社開発の革新、性能でリード

dots.vlm1の核心的な特徴は、ネイティブな自社開発の NaViT ビジュアルエンコーダー です。伝統的な完成されたモデルを微調整する方法とは異なり、NaViT はゼロからトレーニングされ、動的解像度をサポートしており、多様な現実的な画像シーンに適応できます。このモデルは純粋なビジュアルとテキストビジュアルの二重の監督を組み合わせることで、汎用性を大幅に向上させ、特に表やチャート、数式、ドキュメントなどの非典型的な構造化画像の処理において優れた性能を発揮します。

データに関しては、Hi Labチームは大規模で洗浄が厳密なトレーニングデータセットを構築しました。ウェブページのデータを自社で再作成し、自社開発の dots.ocr ツールでPDF文書を処理することで、図形とテキストの対応品質を著しく向上させ、モデルのマルチモーダル理解能力の堅固な基礎を築きました。

評価結果、トップクラスの閉鎖型モデルと匹敵

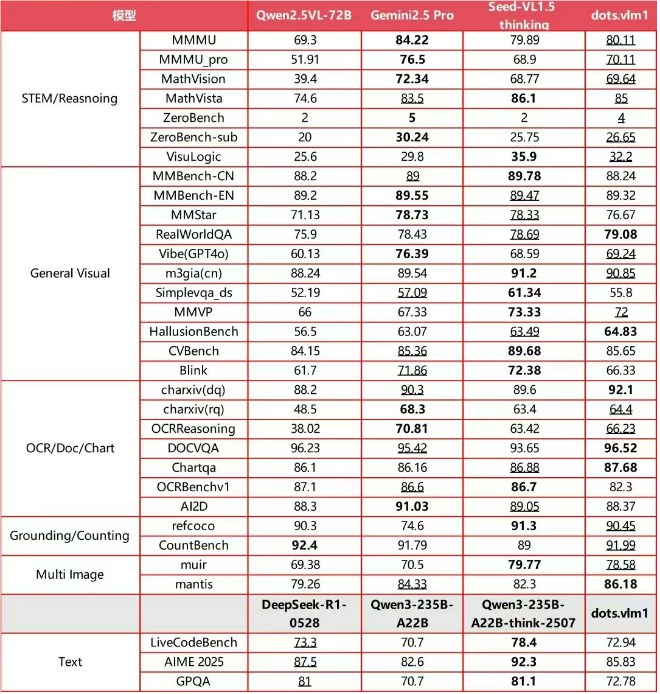

主要な国際マルチモーダル評価セットにおいて、dots.vlm1の総合的なパフォーマンスは注目すべきものです。MMMU、MathVision、OCR Reasoningなどの複数のベンチマークテストにおいて、Gemini2.5ProやSeed-VL1.5と同等のレベルに達しています。複雑なチャート推論、STEM数学推論、および長尾の細分化されたシナリオ認識などのアプリケーションにおいて、dots.vlm1は優れた論理的推論と分析能力を示し、オリンピック算数などの高度なタスクにも対応可能です。

しかし、極めて複雑なテキスト推論タスクではSOTAの閉鎖型モデルにはまだ差がありますが、汎用的な数学推論とコード能力は主流の大規模言語モデルと同等です。

Hi Labチームは、今後もモデルの最適化を続ける予定です。彼らはマルチモーダルデータの規模を拡大し、強化学習などの最先端のアルゴリズムを取り入れて、さらに推論の汎用性を向上させる計画です。dots.vlm1をオープンソース化することで、小紅書はマルチモーダル大規模モデルエコシステムに新たな力をもたらし、業界の発展を推進することを目指しています。