小紅書 Hi Lab 近日發佈並開源了其首個自研多模態大模型 dots.vlm1。該模型基於12億參數的 NaViT 視覺編碼器 和 DeepSeek V3大語言模型,從零開始完全訓練,其卓越性能在多模態視覺理解與推理能力上已接近當前領先的閉源模型,如 Gemini2.5Pro 和 Seed-VL1.5,標誌着開源多模態模型的性能達到了新的高度。

自研創新,性能領跑

dots.vlm1的核心亮點在於其原生自研的 NaViT 視覺編碼器。與傳統基於成熟模型微調的方式不同,NaViT 從零訓練,並支持動態分辨率,能夠更好地適應多樣化的真實圖像場景。該模型還通過結合純視覺與文本視覺的雙重監督,極大提升了其泛化能力,尤其是在處理表格、圖表、公式、文檔等非典型結構化圖片時表現出色。

在數據方面,Hi Lab 團隊構建了規模龐大且清洗精細的訓練集。他們通過自主重寫網頁數據和自研 dots.ocr 工具處理 PDF 文檔,顯著提升了圖文對齊的質量,爲模型的跨模態理解能力打下了堅實基礎。

評測表現,媲美頂尖閉源模型

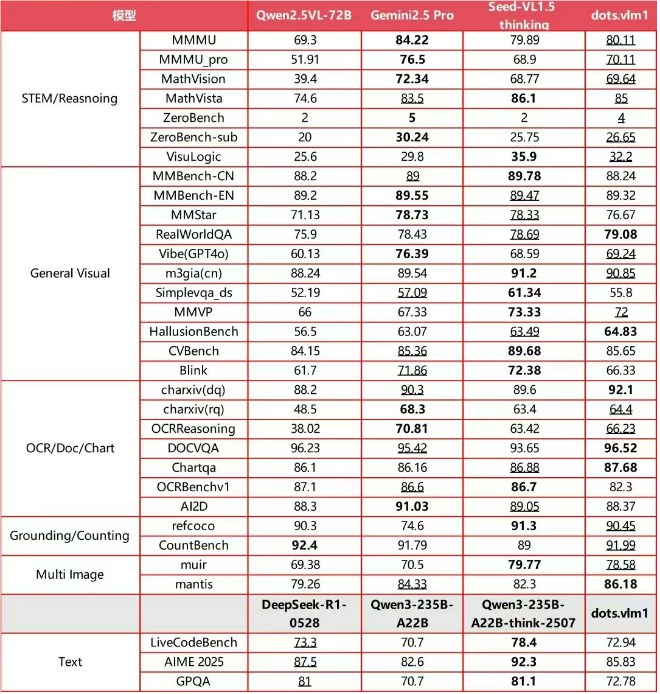

在主流國際多模態評測集上,dots.vlm1的綜合表現令人矚目。它在 MMMU、MathVision 和 OCR Reasoning 等多項基準測試中,達到了與 Gemini2.5Pro 和 Seed-VL1.5相當的水平。在複雜的圖表推理、STEM 數學推理以及長尾細分場景識別等應用中,dots.vlm1展現出卓越的邏輯推理和分析能力,完全勝任奧數等高難度任務。

儘管在文本推理的極複雜任務上與 SOTA 閉源模型仍有差距,但其通用數學推理和代碼能力已與主流大語言模型持平。

Hi Lab 團隊表示,未來將繼續優化模型。他們計劃擴大跨模態數據規模,並引入強化學習等前沿算法,進一步提升推理泛化能力。通過開源 dots.vlm1,小紅書致力於爲多模態大模型生態系統帶來新的動力,推動行業發展。