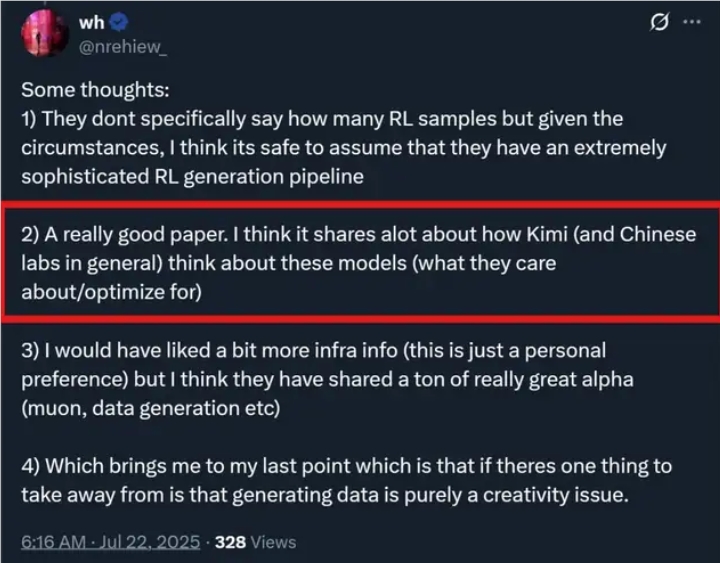

このたび、KimiチームはKimi K2の技術報告を正式に公開し、この新しいモデルの裏にあるトレーニングの秘密を明らかにしました。Kimi K2のパラメータ総数は1兆となり、アクティブパラメータは320億に達しています。その強力な能力により、Kimi K2はリリース後1週間で世界中のオープンソースモデルコンペティションで優勝を果たし、DeepSeekを上回り、Grok4やGPT4.5などのトップクラスのクローズドソースモデルと同等の性能を発揮しました。

Kimi K2の成功は、革新的なトレーニング方法とテクノロジー構造によって支えられています。まず、このチームは従来のAdamオプティマイザに代わってMuonClipオプティマイザを導入しました。この新しいオプティマイザは効率的なトークン使用と安定性を組み合わせており、Kimi K2は予備トレーニング段階で15.5兆のトークンデータを損失なく処理できました。また、チームは複数の分野とツールをカバーする大規模なAgentic Tool Useデータ合成パイプラインを開発し、モデルに豊富なトレーニング環境を提供しました。

注目すべきは、Kimi K2がトレーニング中に「再説明法」を使用してデータ効率を向上させた点です。この方法は単純な繰り返しではなく、知識内容を異なる方法で再表現することで、モデルが情報の本質を理解できるようにすることです。特に数学や知識関連のテキストを処理する際には、複雑な内容を分かりやすい学習ノートスタイルに再構成することで、トレーニング効果をさらに高めています。データによると、再構成されたデータで1ラウンドトレーニングを行うと、元のデータで10ラウンドトレーニングを行うよりも高い正確性が得られることが確認されています。

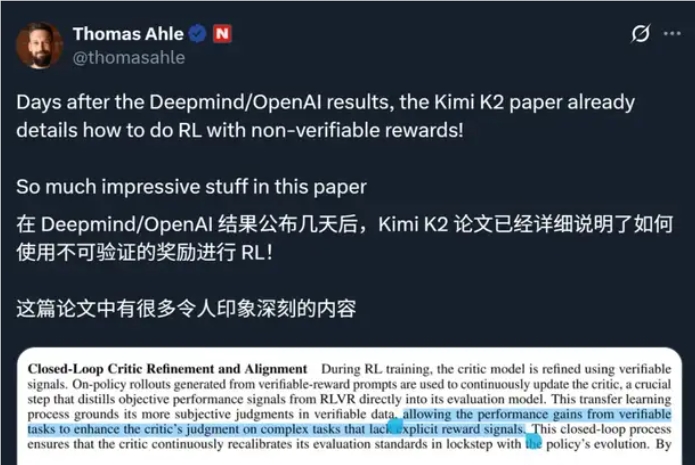

後期トレーニング段階では、Kimi K2は監督的微調整と強化学習が行われました。可検証性のある報酬環境と自己評価メカニズムを構築することで、モデルが多様なタスクにおいて継続的にパフォーマンスを最適化できるようにしました。トレーニング中に予算制御と温度減衰戦略も導入され、生成されるテキストの品質と安定性が向上しました。

このような大規模なトレーニング要件をサポートするために、Kimi K2はNVIDIA H800で構成された大規模な高帯域幅GPUクラスタに依存しており、トレーニング効率とデータ伝送の効率性を確保しています。