近日,Kimi 團隊正式發佈了 Kimi K2的技術報告,揭示了這款全新模型背後的訓練祕密。Kimi K2的參數總量達到1萬億,而激活參數則高達320億,憑藉其強大的能力,Kimi K2在剛上線一週內便在全球開源模型競賽中斬獲桂冠,超越了 DeepSeek,堪比 Grok4和 GPT4.5等頂尖閉源模型。

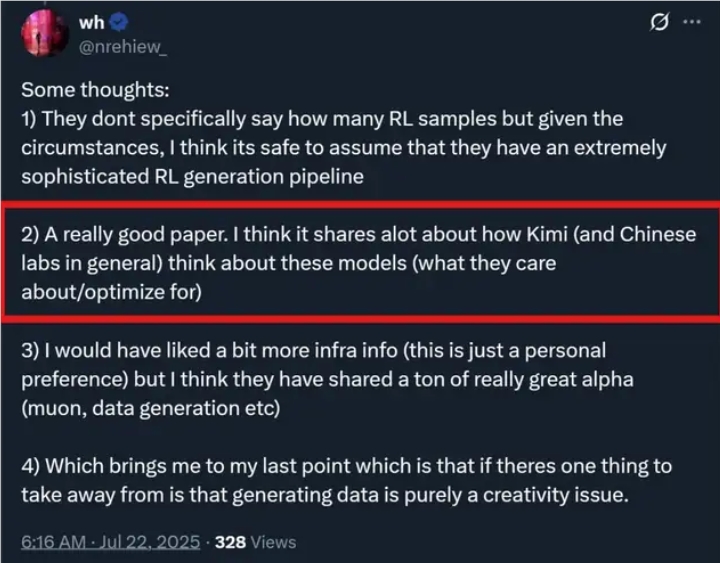

Kimi K2的成功,得益於其創新的訓練方法和技術架構。首先,該團隊引入了 MuonClip 優化器,替代了傳統的 Adam 優化器。這種新的優化器結合了高效的 token 使用和穩定性,讓 Kimi K2在預訓練階段無損失地處理了15.5萬億 token 的數據。此外,團隊還開發了大規模的 Agentic Tool Use 數據合成 pipeline,覆蓋多個領域和工具,爲模型提供了豐富的訓練場景。

值得注意的是,Kimi K2在訓練中採用了 “重述法” 來提高數據效率。這種方法不是簡單重複,而是用不同的方式重新表達知識內容,確保模型能夠真正理解信息。尤其是在處理數學和知識類文本時,Kimi K2通過將複雜內容改寫成易懂的學習筆記風格,進一步提升了訓練效果。數據顯示,用重寫的數據訓練一輪,其準確率超過了使用原始數據訓練十輪的結果。

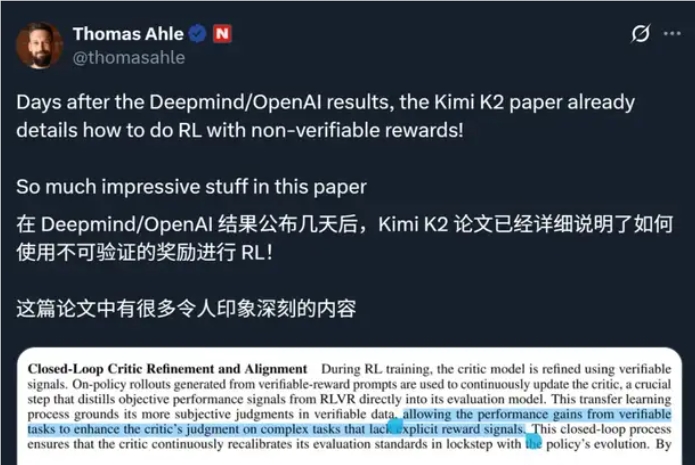

在後訓練階段,Kimi K2還進行了監督微調和強化學習,通過構建可驗證的獎勵環境和自我評估機制,確保模型在多樣化任務中不斷優化表現。訓練過程中還引入了預算控制和溫度衰減策略,以提高生成文本的質量和穩定性。

爲了支持如此龐大的訓練需求,Kimi K2依託於由 NVIDIA H800構成的大規模高帶寬 GPU 集羣,確保了訓練效率和數據傳輸的高效性。

隨着科技的不斷進步,Kimi K2的發佈無疑爲開源模型的發展注入了新的活力,值得行業內外的關注。