近日,Kimi 团队正式发布了 Kimi K2的技术报告,揭示了这款全新模型背后的训练秘密。Kimi K2的参数总量达到1万亿,而激活参数则高达320亿,凭借其强大的能力,Kimi K2在刚上线一周内便在全球开源模型竞赛中斩获桂冠,超越了 DeepSeek,堪比 Grok4和 GPT4.5等顶尖闭源模型。

Kimi K2的成功,得益于其创新的训练方法和技术架构。首先,该团队引入了 MuonClip 优化器,替代了传统的 Adam 优化器。这种新的优化器结合了高效的 token 使用和稳定性,让 Kimi K2在预训练阶段无损失地处理了15.5万亿 token 的数据。此外,团队还开发了大规模的 Agentic Tool Use 数据合成 pipeline,覆盖多个领域和工具,为模型提供了丰富的训练场景。

值得注意的是,Kimi K2在训练中采用了 “重述法” 来提高数据效率。这种方法不是简单重复,而是用不同的方式重新表达知识内容,确保模型能够真正理解信息。尤其是在处理数学和知识类文本时,Kimi K2通过将复杂内容改写成易懂的学习笔记风格,进一步提升了训练效果。数据显示,用重写的数据训练一轮,其准确率超过了使用原始数据训练十轮的结果。

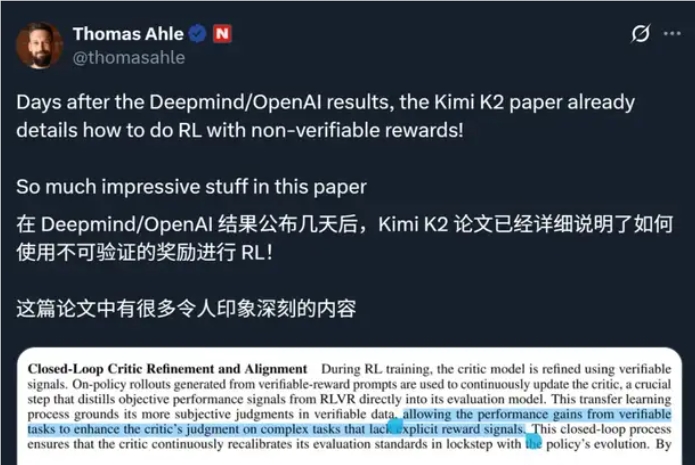

在后训练阶段,Kimi K2还进行了监督微调和强化学习,通过构建可验证的奖励环境和自我评估机制,确保模型在多样化任务中不断优化表现。训练过程中还引入了预算控制和温度衰减策略,以提高生成文本的质量和稳定性。

为了支持如此庞大的训练需求,Kimi K2依托于由 NVIDIA H800构成的大规模高带宽 GPU 集群,确保了训练效率和数据传输的高效性。

随着科技的不断进步,Kimi K2的发布无疑为开源模型的发展注入了新的活力,值得行业内外的关注。