在现代 AI 模型中,如何保持合成数据的新鲜性和多样性而不让单一的调度管道成为瓶颈?Meta AI 的研究人员近日推出了 Matrix,一个去中心化的框架,通过将控制和数据流序列化为消息,分布在不同的队列中进行处理。

随着大型语言模型(LLM)训练日益依赖合成对话、工具轨迹和推理链,现有系统通常依赖中心控制器或特定领域的设置,这会浪费 GPU 资源,增加协调开销并限制数据多样性。而 Matrix 采用了基于 Ray 集群的点对点智能体调度,相比之下,能够在真实工作负载中提供2到15倍的更高令牌吞吐量,同时保持相似的质量。

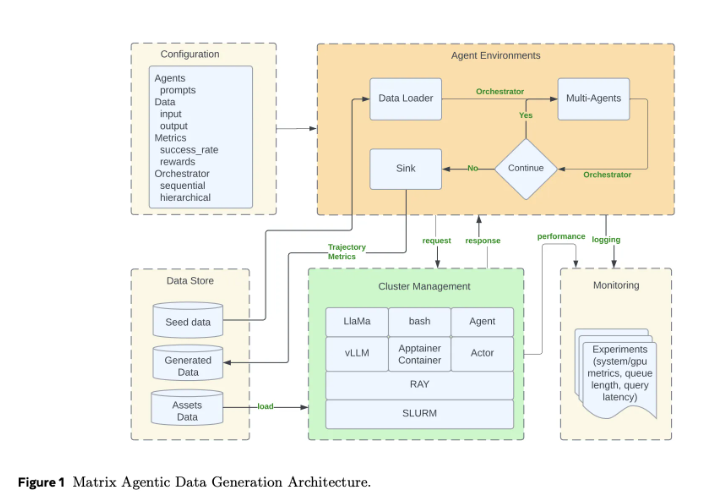

传统的智能体框架通常将工作流状态和控制逻辑保留在中心调度器中,所有的智能体调用和工具调用都必须经过这个控制器。这种模式虽然易于理解,但在需要成千上万并发合成对话时却难以扩展。而 Matrix 的设计则将控制流和数据流序列化成一个名为 “调度器” 的消息对象。每个无状态的智能体作为 Ray 的 actor,从分布式队列中获取调度器,应用其特定逻辑后将状态更新并直接发送给下一个智能体。这种设计减少了不同轨迹长度差异带来的空闲时间,故障处理也变得更加局部化。

Matrix 运行在 Ray 集群上,通常通过 SLURM 启动。Ray 提供了分布式智能体和队列,而 Hydra 管理智能体角色、调度器类型和资源配置。该框架还引入了消息卸载,当对话历史超过阈值时,大量负载被存储在 Ray 的对象存储中,仅保留对象标识符在调度器中,从而减少集群带宽。

通过三个案例研究,Matrix 展示了其强大的性能:在 Collaborative Reasoner 的对话生成中,Matrix 的令牌吞吐量达到2亿,相比之下,传统方法仅为0.62亿;在 NaturalReasoning 数据集构建中,Matrix 的吞吐量提升了2.1倍;在 Tau2-Bench 工具使用轨迹评估中,Matrix 提供了15.4倍的吞吐量。Matrix 的设计不仅提升了吞吐量,还保持了输出质量,展示了高效的合成数据生成能力。

论文:https://arxiv.org/pdf/2511.21686

划重点:

🌟 Matrix 框架采用去中心化设计,避免了传统中心调度器的瓶颈。

🚀 在多项案例研究中,Matrix 展现出2到15倍的令牌吞吐量提升。

🔧 该框架充分利用 Ray 集群的分布式特性,实现高效的合成数据生成与处理。