在現代 AI 模型中,如何保持合成數據的新鮮性和多樣性而不讓單一的調度管道成爲瓶頸?Meta AI 的研究人員近日推出了 Matrix,一個去中心化的框架,通過將控制和數據流序列化爲消息,分佈在不同的隊列中進行處理。

隨着大型語言模型(LLM)訓練日益依賴合成對話、工具軌跡和推理鏈,現有系統通常依賴中心控制器或特定領域的設置,這會浪費 GPU 資源,增加協調開銷並限制數據多樣性。而 Matrix 採用了基於 Ray 集羣的點對點智能體調度,相比之下,能夠在真實工作負載中提供2到15倍的更高令牌吞吐量,同時保持相似的質量。

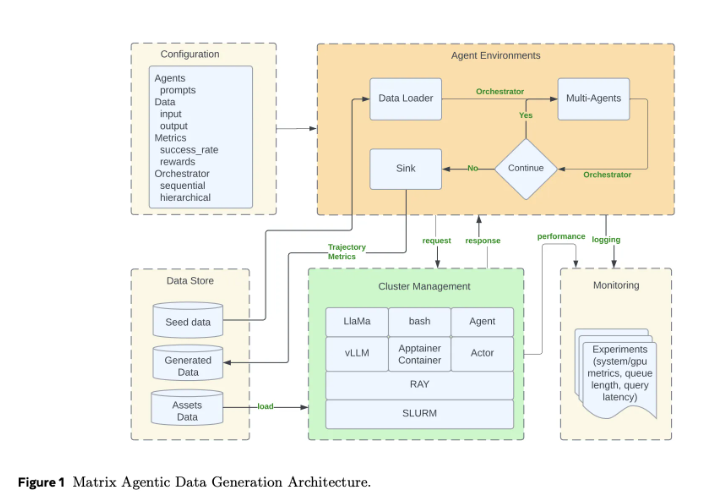

傳統的智能體框架通常將工作流狀態和控制邏輯保留在中心調度器中,所有的智能體調用和工具調用都必須經過這個控制器。這種模式雖然易於理解,但在需要成千上萬併發合成對話時卻難以擴展。而 Matrix 的設計則將控制流和數據流序列化成一個名爲 “調度器” 的消息對象。每個無狀態的智能體作爲 Ray 的 actor,從分佈式隊列中獲取調度器,應用其特定邏輯後將狀態更新並直接發送給下一個智能體。這種設計減少了不同軌跡長度差異帶來的空閒時間,故障處理也變得更加局部化。

Matrix 運行在 Ray 集羣上,通常通過 SLURM 啓動。Ray 提供了分佈式智能體和隊列,而 Hydra 管理智能體角色、調度器類型和資源配置。該框架還引入了消息卸載,當對話歷史超過閾值時,大量負載被存儲在 Ray 的對象存儲中,僅保留對象標識符在調度器中,從而減少集羣帶寬。

通過三個案例研究,Matrix 展示了其強大的性能:在 Collaborative Reasoner 的對話生成中,Matrix 的令牌吞吐量達到2億,相比之下,傳統方法僅爲0.62億;在 NaturalReasoning 數據集構建中,Matrix 的吞吐量提升了2.1倍;在 Tau2-Bench 工具使用軌跡評估中,Matrix 提供了15.4倍的吞吐量。Matrix 的設計不僅提升了吞吐量,還保持了輸出質量,展示了高效的合成數據生成能力。

論文:https://arxiv.org/pdf/2511.21686

劃重點:

🌟 Matrix 框架採用去中心化設計,避免了傳統中心調度器的瓶頸。

🚀 在多項案例研究中,Matrix 展現出2到15倍的令牌吞吐量提升。

🔧 該框架充分利用 Ray 集羣的分佈式特性,實現高效的合成數據生成與處理。