谷歌近日为其 Gemini2.5AI 模型推出了一项创新功能——“对话式图像分割”,允许用户通过自然语言提示直接分析和突出显示图像内容。这项技术超越了传统的图像分割范畴,赋予 Gemini 理解并响应更复杂、更具语义的指令的能力。

超越传统,理解抽象与关系

传统图像分割通常局限于识别如“狗”、“汽车”或“椅子”等固定类别的物体。而现在,Gemini 可以理解并应用于图像特定部分的更复杂语言。它能够处理:关系查询:例如“撑伞的人”。基于逻辑的指令:例如“所有非坐着的人”。抽象概念:甚至能识别“杂物”或“损坏”等没有清晰视觉轮廓的概念。

此外,得益于内置的文本识别功能,Gemini 还能识别需要阅读屏幕文本的图像元素,例如展示柜中的“开心果果仁蜜饯”。该功能支持多语言提示,并可按需提供其他语言(如法语)的物体标签。

广泛应用:从设计到安全再到保险

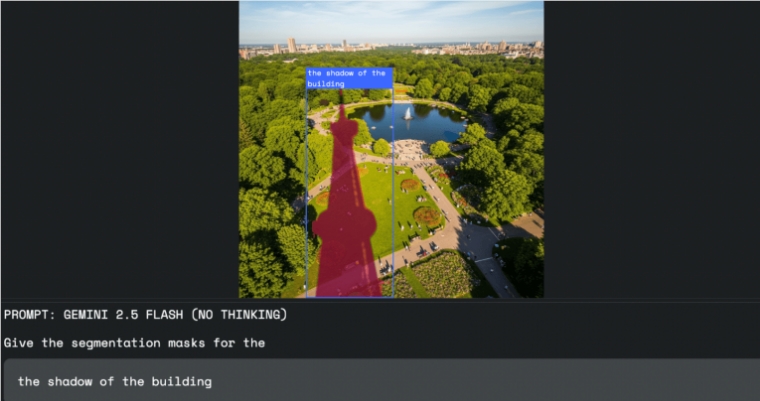

谷歌表示,这项技术在多个领域都具有广泛的实际应用价值:图像编辑:设计师无需鼠标或选择工具,只需口头指令,如“选择建筑物的阴影”,即可精准选中所需区域。工作场所安全:Gemini 可以扫描照片或视频,自动识别违规行为,例如“施工现场所有未戴头盔的人”。保险行业:理赔员可以发出“突出显示所有遭受风暴破坏的房屋”等命令,自动在航拍图像中标记受损建筑,大幅节省手动检查时间。

开发者友好:API 访问与优化建议

这项强大的功能无需特殊的独立模型。开发者可以通过 Gemini API 直接访问“对话式图像分割”功能,所有请求均由具备此功能的 Gemini 模型直接处理。

返回的结果以 JSON 格式呈现,包含所选图像区域的坐标(box_2d)、像素掩码(mask)和描述性标签(label),为后续开发提供便利。

为获得最佳效果,谷歌建议使用 gemini-2.5-flash 模型,并将 thinkingBudget 参数设置为零以触发即时响应。开发者可以通过 Google AI Studio 或 Python Colab 进行初步测试。