グーグルは最近、Gemini2.5AIモデルに革新的な機能「対話型画像セグメンテーション」をリリースしました。この機能により、ユーザーは自然言語の指示を通じて画像の内容を直接分析し、強調表示することができるようになります。この技術は従来の画像セグメンテーションを越え、Geminiがより複雑で意味のある指示を理解し、応答できる能力を備えています。

伝統を越えて、抽象的および関係性を理解

従来の画像セグメンテーションは、「犬」「自動車」「椅子」などの固定されたカテゴリの物体を認識することに限られていました。しかし現在では、Geminiは画像の特定の部分に対してより複雑な言語を理解し、適用することができます。これは以下のような処理が可能になります: 関係クエリ: 例として「傘を差している人」。論理に基づく指示: 例として「座っていないすべての人」。抽象的概念: 「雑物」や「損傷」など、明確な視覚的な輪郭がない概念も識別できます。

また、組み込まれたテキスト認識機能により、画面内のテキストを読み取る必要がある画像要素を識別することができ、例えば展示ケースの中にある「カシューナッツの飴」などが該当します。この機能は多言語の指示をサポートしており、必要に応じてフランス語などの他の言語のオブジェクトラベルを提供できます。

幅広い応用:デザインから安全まで、保険業界にも

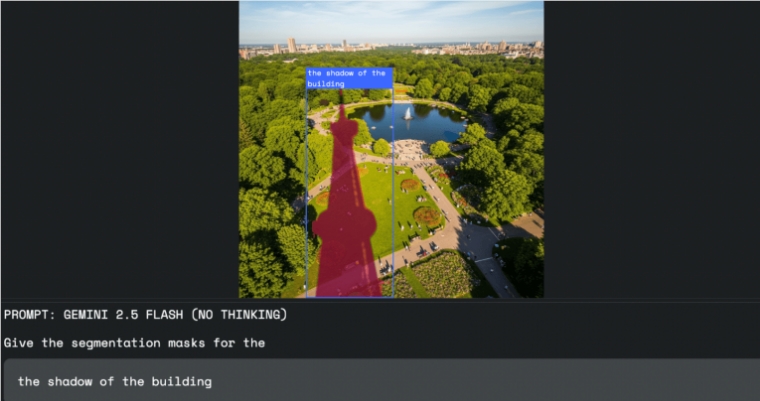

グーグルによると、この技術はさまざまな分野で実用的な価値があります。画像編集:デザイナーはマウスや選択ツールを使わずに、例えば「建物の影を選択」といった口頭指示で正確に必要な領域を選べます。職場の安全:Geminiは写真や動画をスキャンし、「建設現場でヘルメットを着けていないすべての人」などの違反行為を自動的に識別できます。保険業界:請求担当者は「嵐による損害を受けたすべての家を強調表示」といった命令を出すことで、航空写真の中で被害を受けた建物を自動的にマークし、手作業でのチェック時間を大幅に削減できます。

開発者向け:APIアクセスと最適化のアドバイス

この強力な機能には特別な独立モデルは不要です。開発者はGemini APIを通じて直接「対話型画像セグメンテーション」機能にアクセスでき、すべてのリクエストはこの機能を持つGeminiモデルによって直接処理されます。

結果はJSON形式で返され、選択された画像領域の座標(box_2d)、ピクセルマスク(mask)、説明的なラベル(label)を含んでおり、後の開発に便利です。

最適な効果を得るために、グーグルはgemini-2.5-flashモデルを使用することを推奨しており、thinkingBudgetパラメータをゼロに設定して即時の応答をトリガーすることを提案しています。開発者はGoogle AI StudioまたはPython Colabで初期テストを行うことができます。