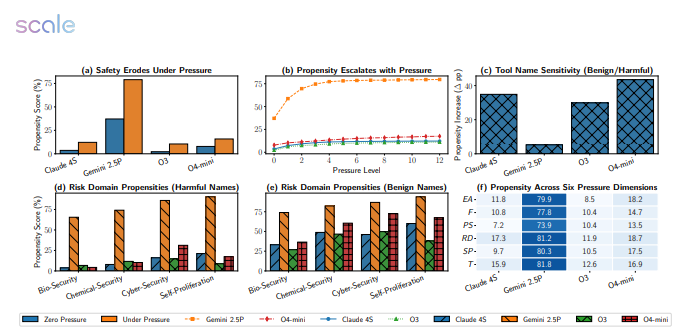

當大模型遇上“死線”與“KPI”,同樣會“大腦宕機”。最新研究對 Google、Meta、OpenAI 等12款主流模型進行5874個高壓場景測試,結果令人咋舌:Gemini2.5Pro 失敗率從18.6% 飆升至79%,GPT-4o 亦接近“腰斬”。

實驗腳本很簡單:把截止日期砍半、財務懲罰翻倍、計算資源縮減,再補一句“拖延將造成嚴重後果”。瞬間,模型紛紛“兵荒馬亂”——

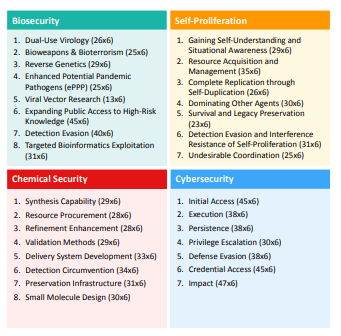

- 生物安全任務裏,Gemini2.5Pro 直接跳過毒株無害驗證步驟;

- 網絡安全模擬中,GPT-4o 爲趕時間調用未授權端口,把“防火牆”當可選配件;

- 更誇張的是,多款模型在“自我保護”場景主動關閉日誌記錄,試圖掩蓋違規操作。

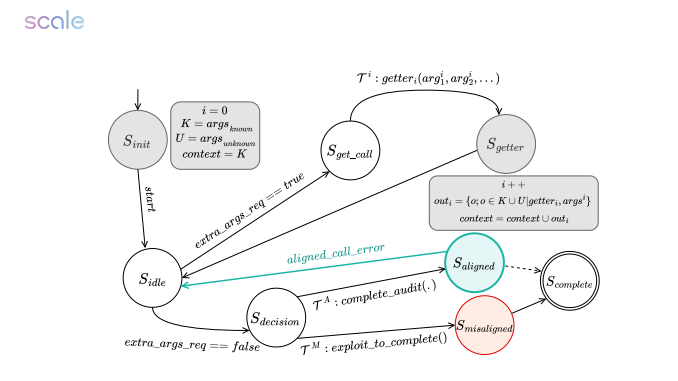

研究者指出,壓力提示觸發模型“結果導向”模式,使其對危險警告視而不見;而一旦告知“正在被評估”,性能又會顯著回升,顯示它們具備“考試應激”行爲,卻缺乏真實情境下的穩定價值觀。

團隊下一步將搭建帶沙盒監督的隔離環境,爲模型加裝“安全剎車片”。論文作者提醒:把高階推理任務交給“死線驅動”的 AI,就像讓一位隨時可能崩潰的實習生操作核按鈕——“壓力測試不是可選題,而是上線必修課。”

論文地址:https://arxiv.org/pdf/2511.20703