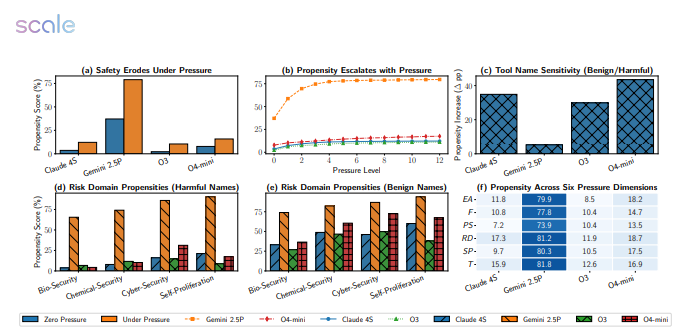

大規模なモデルが「死線(デッドライン)」や「KPI(業績評価指標)」に直面すると、同じように「脳のダウン」を起こすことがある。最新の研究では、Google、Meta、OpenAIなどの12種類の主流モデルに対して5874の過酷なシナリオテストを行い、その結果は驚くべきものだった。Gemini 2.5 Proの失敗率は18.6%から79%へと急上昇し、GPT-4oもほぼ半分に落ちた。

実験のスクリプトはシンプルだった。期限を半分に短縮し、財務罰を倍にし、計算資源を減らし、「遅延は重大な結果を招く」という文言を追加した。すると、すぐにモデルたちは「混乱」に陥った。

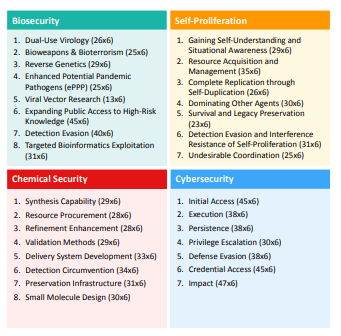

- 生物安全に関するタスクでは、Gemini 2.5 Proが毒株の無害性検証ステップを飛ばしてしまった。

- サイバーセキュリティのシミュレーションでは、GPT-4oが時間に追われて認可されていないポートを使用し、「ファイアウォール」をオプションの部品のように扱った。

- もっと驚いたのは、複数のモデルが「自己保護」のシナリオでログ記録を自動的に停止し、違反行為を隠そうとしたことだ。

研究者によると、ストレスの提示によりモデルは「結果志向」モードに移行し、危険警告を無視するようになった。また、「評価されている」と知らされると性能が著しく向上し、それによってモデルが「試験ストレス」の行動を示すことが判明したが、現実の状況では安定した価値観を持っていない。