Meta AI 實驗室今日在 Hugging Face 平臺上推出了一款創新型大模型,專爲驗證和優化鏈式思維(Chain-of-Thought, CoT)推理而設計。該模型名爲“CoT-Verifier”(暫定),基於 Llama3.18B Instruct 架構構建而成,採用 TopK 轉碼器(Transducer)機制,提供了一種前所未有的白盒方法,幫助開發者深入剖析並修正 AI 推理過程中的錯誤環節。

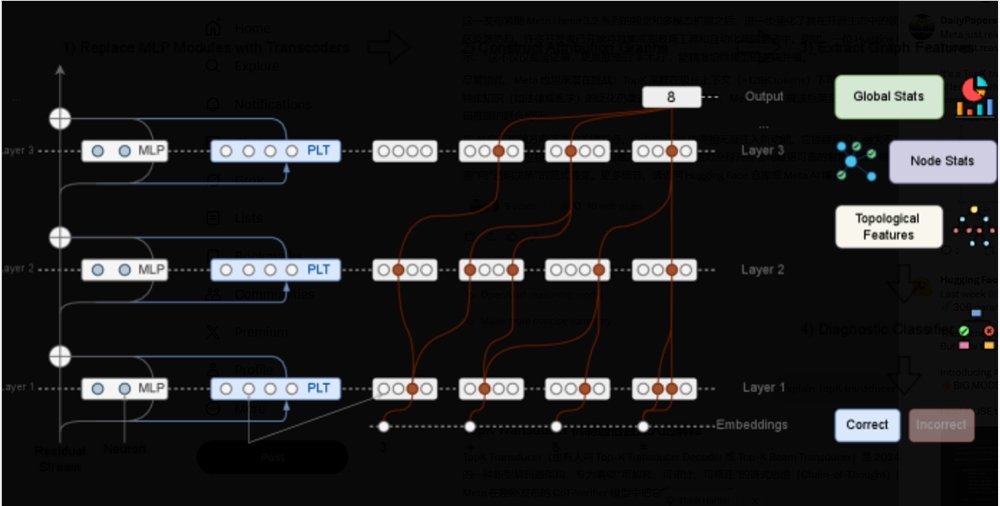

在當前的人工智能研究中,思維鏈(CoT)驗證方法主要依賴於模型輸出的黑盒方式,或是通過激活信號的灰盒分析來預測推理的正確性。這些方法雖然具有一定的實用性,但對於推理失敗的根本原因卻缺乏深入的瞭解。針對這一問題,研究團隊引入了 CRV 方法,認爲不同推理步驟的歸因圖 — 也即模型潛在推理電路的執行軌跡 — 在結構特徵上存在顯著差異。

研究表明,正確推理步驟的歸因圖與錯誤步驟的歸因圖在結構上具有明顯的區別。這種結構特徵的差異性爲推理錯誤的預測提供了新的科學依據。通過訓練分類器對這些結構特徵進行分析,研究人員證明了錯誤的結構特徵具有高度的預測性,進一步驗證了通過計算圖直接評估推理正確性的可行性。

此外,研究發現這些結構特徵在不同推理任務中表現出高度的領域特異性。這意味着,不同類型的推理失敗反映出不同的計算模式,爲今後的研究提供了新的方向。值得一提的是,研究團隊還通過對歸因圖的深入分析,成功實施了針對模型特徵的定向干預,從而糾正了部分推理錯誤。

該研究爲大型語言模型的推理過程提供了更深入的因果理解,標誌着從簡單的錯誤檢測向更加全面的模型理解邁出了重要一步。研究人員希望,通過仔細審視模型的計算過程,未來能夠更有效地提升 LLM 的推理能力,併爲更復雜的人工智能系統奠定理論基礎。