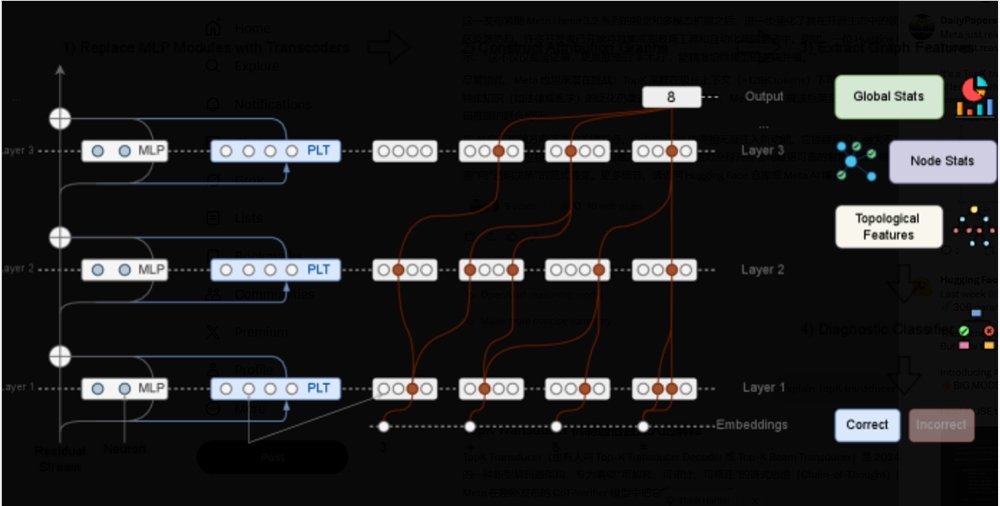

Meta AI ラボは本日、Hugging Faceプラットフォームで革新的な大規模モデルをリリースしました。このモデルは、チェーン・オブ・シンス(Chain-of-Thought、CoT)推論の検証と最適化を専門に設計されています。「CoT-Verifier」(仮称)と名付けられたこのモデルは、Llama3.18B Instructアーキテクチャに基づいて構築されており、TopKトランスデューサー(Transducer)メカニズムを使用しています。これは、開発者がAIの推論プロセスにおける誤りの部分を深く分析し修正するための画期的なホワイトボックス方法を提供します。

現在の人工知能研究において、思考連鎖(CoT)検証方法は主にモデル出力のブラックボックス方式や、アクティベーション信号のグレーボックス分析によって推論の正しさを予測するものとなっています。これらの方法は一定の実用性を持っていますが、推論に失敗する根本的な原因については十分な理解が得られていません。この問題に対処するために、研究チームはCRV(因果的帰因検証)手法を導入し、異なる推論ステップの帰因図、つまりモデルの潜在的な推論回路の実行軌跡が構造的特徴において明確な違いを持つことを示しました。

研究によると、正しい推論ステップの帰因図と誤ったステップの帰因図は構造的に明確な違いを持っていることがわかりました。このような構造的特徴の違いは、推論エラーの予測に新たな科学的根拠を提供します。これらの構造的特徴を分析する分類器を訓練することで、研究者たちは誤りの構造的特徴が非常に高い予測性を持つことを実証し、推論の正しさを計算グラフから直接評価することが可能であることをさらに確認しました。

また、研究ではこれらの構造的特徴が異なる推論タスクにおいて高いドメイン特異性を示すことが明らかになりました。これは、異なるタイプの推論失敗が異なる計算パターンを反映していることを意味し、今後の研究にとって新しい方向性を示しています。注目すべき点として、研究チームは帰因図の詳細な分析を通じて、モデルの特徴に対して特定の干渉を成功させ、一部の推論エラーを修正することに成功しました。

この研究は、大規模言語モデルの推論プロセスに対するより深い因果的理解を提供し、単なるエラー検出からより包括的なモデル理解への重要な一歩を踏み出しました。研究者たちは、モデルの計算プロセスを丁寧に見直すことで、将来、LLMの推論能力をより効果的に向上させ、より複雑な人工知能システムの理論的基盤を築くことを期待しています。