近日,亞馬遜網絡服務(AWS)發佈了一項新功能,允許用戶通過 Amazon Bedrock Custom Model Import 輕鬆部署開源的 GPT-OSS 模型。

這一新功能支持包含20億和120億參數的 GPT-OSS 變體,幫助企業在保留 API 兼容性的前提下,遷移現有應用程序到 AWS 平臺。使用此功能,用戶只需將模型文件上傳至 Amazon S3,然後通過 Amazon Bedrock 控制檯啓動導入,AWS 會自動處理 GPU 的配置、推理服務器的搭建和按需自動擴展,用戶可以專注於應用開發。

GPT-OSS 模型是 OpenAI 推出的首批開源語言模型,適用於多種應用,包括推理和工具使用。用戶可以根據需求選擇合適的模型,其中 GPT-OSS-20B 適合速度和效率至關重要的場景,而 GPT-OSS-120B 則更適合複雜推理任務。兩款模型均採用專家混合架構,僅在請求時激活最相關的模型組件,保證高效性能。

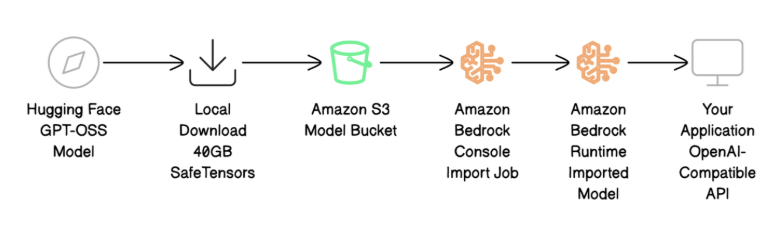

部署過程包含四個主要步驟:下載並準備模型文件、將文件上傳至 Amazon S3、使用 Amazon Bedrock 進行模型導入以及通過 OpenAI 兼容的 API 調用測試模型。用戶需確保擁有 AWS 賬號及適當權限,並在目標區域創建 S3存儲桶。完成模型導入後,用戶可使用熟悉的 OpenAI 聊天完成 API 格式進行測試,確保模型正常運行。此外,遷移到 AWS 的過程代碼更改極少,僅需更改調用方式,消息結構保持不變。

在使用新功能的同時,AWS 還建議用戶遵循一些最佳實踐,如文件驗證和安全性設置,以確保模型部署的順利進行。AWS 將繼續擴大 Bedrock 服務的區域支持,以滿足更多用戶需求。

劃重點:

🌟 AWS 推出 Amazon Bedrock Custom Model Import 功能,支持 GPT-OSS 模型的輕鬆部署。

💡 用戶只需上傳模型文件,AWS 將自動處理基礎設施配置與擴展。

🔄 遷移至 AWS 平臺的過程簡單,API 兼容性保證現有應用無縫過渡。