最近、アマゾン・ウェブ・サービス(AWS)は、ユーザーがAmazon Bedrock Custom Model Importを通じてオープンソースのGPT-OSSモデルを簡単にデプロイできるようになった新しい機能をリリースしました。

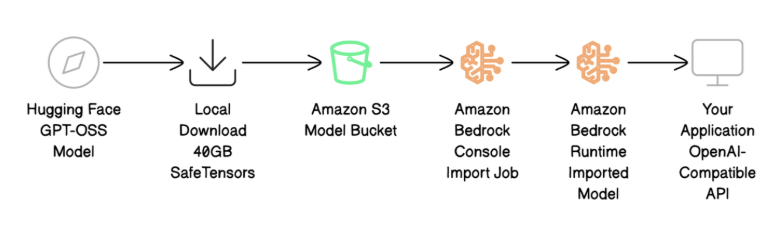

この新機能は、20億パラメータと120億パラメータを持つGPT-OSSのバリエーションをサポートしており、企業が既存のアプリケーションをAWSプラットフォームに移行する際にAPI互換性を維持しながら、効率的に移行できるようにします。この機能を使用すると、ユーザーはモデルファイルをAmazon S3にアップロードし、Amazon Bedrockコンソールでインポートを開始するだけで、AWSがGPUの設定や推論サーバーの構築、必要に応じた自動拡張を自動的に行います。ユーザーはアプリケーション開発に集中できます。

GPT-OSSモデルはOpenAIが最初に公開したオープンソース言語モデルであり、推論やツールの使用など多くの用途に適しています。ユーザーは自分のニーズに応じて適切なモデルを選択でき、GPT-OSS-20Bは速度と効率が重要なシナリオに最適で、GPT-OSS-120Bは複雑な推論タスクに適しています。両モデルとも専門家混合アーキテクチャを採用しており、リクエスト時に最も関連性のあるモデルコンポーネントのみをアクティブ化することで、効率的な性能を保証しています。

デプロイプロセスには4つの主要なステップがあります:モデルファイルをダウンロードして準備する、ファイルをAmazon S3にアップロードする、Amazon Bedrockを使ってモデルをインポートする、そしてOpenAI互換のAPIを使ってモデルをテストする。ユーザーはAWSアカウントと適切な権限を持ち、対象のリージョンでS3バケットを作成する必要があります。モデルのインポートが完了したら、ユーザーは慣れ親しんだOpenAIチャット完成API形式を使ってモデルをテストし、モデルが正常に動作していることを確認できます。また、AWSへの移行プロセスではコード変更がほとんどなく、呼び出し方法を変更するだけで済み、メッセージ構造は変更されません。

新機能を使用する際、AWSはいくつかのベストプラクティスを推奨しており、例えばファイルの検証やセキュリティ設定など、モデルのデプロイをスムーズに行うために重要です。AWSは引き続きBedrockサービスのリージョンサポートを拡大し、より多くのユーザーのニーズに対応していきます。

ポイント:

🌟 AWSはAmazon Bedrock Custom Model Import機能をリリースし、GPT-OSSモデルの簡単なデプロイを可能にしました。

💡 ユーザーはモデルファイルをアップロードするだけで、AWSがインフラストラクチャの設定と拡張を自動的に行います。

🔄 AWSプラットフォームへの移行プロセスは簡単で、API互換性により既存のアプリケーションがスムーズに移行できます。